ریاضیات پشت مدلها و ترانسفورماتورهای زبان بزرگ - آخرین آپدیت

Mathematics Behind Large Language Models and Transformers

به ریاضیات ترانسفورماتورها خوش آمدید، یک دوره آموزشی عمیق که برای کسانی که مشتاق درک مبانی ریاضی مدل های زبان بزرگ مانند GPT، BERT و فراتر از آن هستند، ساخته شده است. این دوره به الگوریتم های پیچیده ریاضی می پردازد که به این مدل های پیچیده اجازه می دهد تا متنی شبیه انسان را پردازش، درک و تولید کنند. با شروع توکنسازی، دانشآموزان یاد خواهند گرفت که چگونه متن خام از طریق تکنیکهایی مانند الگوریتم WordPiece به قالبی قابل درک توسط مدلها تبدیل میشود. ما اجزای اصلی معماری ترانسفورماتور - ماتریس های کلیدی، ماتریس های پرس و جو و ماتریس های ارزش - و نقش آنها در رمزگذاری اطلاعات را بررسی خواهیم کرد. تمرکز قابل توجهی بر روی مکانیک مکانیسم توجه خواهد بود، از جمله مطالعات دقیق در مورد توجه چند سر و ماسک های توجه. این مفاهیم در توانمندسازی مدلها برای تمرکز بر بخشهای مربوطه از دادههای ورودی و افزایش توانایی آنها در درک زمینه و تفاوتهای ظریف، محوری هستند. ما همچنین رمزگذاری های موقعیتی را پوشش خواهیم داد که برای حفظ توالی کلمات در ورودی ها، استفاده از توابع کسینوس و سینوسی برای جاسازی اطلاعات موقعیت به صورت ریاضی ضروری هستند. علاوه بر این، این دوره شامل بینشهای جامعی در مورد مدلهای زبان دو طرفه و نقابدار، بردارها، محصولات نقطهای و جاسازیهای چند بعدی کلمات است که برای ایجاد بازنمایی متراکم از کلمات ضروری است. در پایان این دوره، شرکت کنندگان نه تنها به مبانی نظری ترانسفورماتورها تسلط خواهند یافت، بلکه بینش عملی در مورد عملکرد و کاربرد آنها نیز به دست خواهند آورد. این دانش شما را برای نوآوری و برتری در زمینه یادگیری ماشین آماده می کند و شما را در میان برترین مهندسان و محققان هوش مصنوعی قرار می دهد

بررسی اجمالی دوره Course Overview

-

آنچه را که قرار است پوشش دهیم What we are going to Cover

توکن سازی و جاسازی کلمات چند بعدی Tokenization and Multidimensional Word Embeddings

-

مقدمه ای بر توکن سازی Introduction to Tokenization

-

توکن سازی در عمق Tokenization in Depth

-

درک برنامه ای توکن سازی ها Programatically Understanding Tokenizations

-

BERT در مقابل DistilBERT BERT vs. DistilBERT

-

جاسازی ها در یک فضای برداری پیوسته Embeddings in a Continuous Vector Space

کدگذاری های موقعیتی Positional Encodings

-

مقدمه ای بر رمزگذاری های موقعیتی Introduction to Positional Encodings

-

نحوه عملکرد رمزگذاری های موقعیتی How Positional Encodings Work

-

درک شاخص های زوج و فرد با رمزگذاری های موقعیتی Understanding Even and Odd Indicies with Positional Encodings

-

چرا از توابع سینوس و کسینوس برای رمزگذاری های موقعیتی استفاده می کنیم؟ Why we Use Sine and Cosine Functions for Positional Encodings

-

درک ماهیت توابع سینوس و کسینوس Understanding the Nature of Sine and Cosine Functions

-

تجسم رمزگذاری های موقعیتی در نمودارهای سینوسی و کسینوس Visualizing Positional Encodings in Sine and Cosine Graphs

-

حل معادلات برای به دست آوردن رمزگذاری های موقعیتی Solving the Equations to get the Positional Encodings

مکانیزم توجه و معماری ترانسفورماتور Attention Mechanism and Transformer Architecture

-

مقدمه ای بر مکانیسم های توجه Introduction to Attention Mechanisms

-

ماتریس پرس و جو، کلید و ارزش Query, Key, and Value Matrix

-

شروع با محاسبه گام به گام توجه Getting started with our Step by Step Attention Calculation

-

محاسبه بردارهای کلیدی Calculating Key Vectors

-

مقدمه ماتریس پرس و جو Query Matrix Introduction

-

محاسبه امتیازات توجه خام Calculating Raw Attention Scores

-

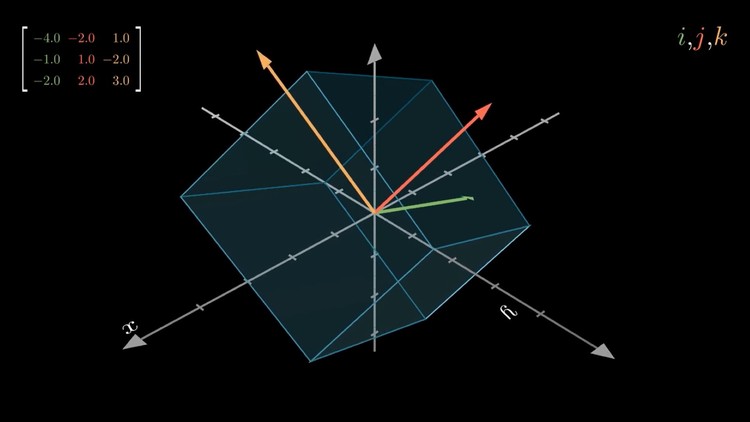

درک ریاضیات پشت محصولات نقطه و تراز برداری Understanding the Mathematics behind Dot products and Vector Alignment

-

تجسم امتیازات توجه خام در 2 بعد Visualising Raw Attention Scores in 2 Dimensions

-

تبدیل امتیاز توجه خام به توزیع احتمال با Softmax Converting Raw Attention Scores to Probability Distributions with Softmax

-

عادی سازی و مقیاس بندی Normalisation and Scaling

-

درک ماتریس ارزش و بردار ارزش Understanding the Value Matrix and Value Vector

-

محاسبه بازنمایی غنی آگاه از زمینه نهایی برای کلمه "رودخانه" Calculating the Final Context Aware Rich Representation for the word "river"

-

درک خروجی Understanding the Output

-

درک توجه چند سر Understanding Multi Head Attention

-

مثال توجه چند سر، و لایه های بعدی Multi Head Attention Example, and Subsequent layers

-

مدل سازی زبان نقاب دار Masked Language Modeling

https://donyad.com/d/7bb5ba

Patrik Szepesi

Patrik Szepesi

مهندس یادگیری ماشین

نمایش نظرات