آموزش بوت کمپ مهندسی داده های بزرگ با GCP و Azure Cloud - آخرین آپدیت

دانلود Big Data Engineering Bootcamp with GCP, and Azure Cloud

آموزش جامع بیگ دیتا: هدوپ، اسپارک، کافکا و ابر (با پروژههای عملی)

آموزش بیگ دیتا با هدوپ (Hadoop)، اسپارک (Spark) و کافکا (Kafka) از صفر تا صد. اصول ۳V (حجم، سرعت، تنوع) دادههای کلان و کاربردهای واقعی آنها را بیاموزید.

مسیر یادگیری متخصص بیگ دیتا: کار با گردش کار ETL، دریافت داده، تبدیل و ذخیره دادهها با استفاده از Apache Spark، Airflow، Kafka و سیستمهای توزیعشده.

پیادهسازی و مدیریت راهکارهای بیگ دیتا روی Azure و GCP.

پروژههای عملی بیگ دیتا: کار روی پروژههای واقعی دادههای کلان، پیادهسازی معماریهای مقیاسپذیر، خطوط لوله داده و تجزیه و تحلیل با استفاده از ابزارهای رایج صنعت.

پیشنیازها

- دانش پایه کامپیوتر: بدون نیاز به تجربه قبلی در بیگ دیتا، آشنایی با کامپیوتر و نرمافزارهای اساسی مفید است.

- دانش پایه پایتون یا SQL (اختیاری): الزامی نیست، اما درک پایه از پایتون یا SQL یادگیری پردازش داده را آسانتر میکند.

- اشتیاق به یادگیری: انگیزه قوی برای کاوش در فناوریهای بیگ دیتا و کار با راهکارهای داده در مقیاس بزرگ ضروری است.

- لپتاپ با دسترسی به اینترنت: هر سیستم (Windows/Mac/Linux) با حداقل ۸ گیگابایت رم برای اجرای ابزارهای بیگ دیتا به صورت محلی یا در ابر توصیه میشود.

توضیحات دوره

در دنیای دادهمحور امروز، سازمانها با حجم عظیمی از دادهها که هر ثانیه تولید میشوند، سروکار دارند. فناوریهای بیگ دیتا برای پردازش، ذخیرهسازی و تجزیه و تحلیل کارآمد این دادهها برای استخراج بینشهای تجاری ضروری شدهاند. این دوره برای مبتدیان، افراد تازهکار یا متخصصان با تجربه که به دنبال انتقال به مهندسی بیگ دیتا هستند، طراحی شده است تا شما را از سطح صفر به سطح متخصص با پروژههای واقعی و End-to-End برساند.

این بوتکمپ جامع بیگ دیتا به شما کمک میکند تا بر پرطرفدارترین فناوریها مانند هدوپ (Hadoop)، آپاچی اسپارک (Apache Spark)، کافکا (Kafka)، Flink و پلتفرمهای ابری مانند AWS، Azure و GCP تسلط پیدا کنید. شما یاد خواهید گرفت که چگونه خطوط لوله داده مقیاسپذیر ایجاد کنید، پردازش دادههای دستهای و بلادرنگ را انجام دهید و با فریمورکهای محاسباتی توزیعشده کار کنید.

ما از اصول اولیه شروع خواهیم کرد، مفاهیم اساسی بیگ دیتا و اکوسیستم آن را توضیح میدهیم و به تدریج به سمت موضوعات پیشرفتهتر حرکت میکنیم و اطمینان حاصل میکنیم که از طریق پروژههای عملی تجربه عملی کسب میکنید.

چه چیزی یاد خواهید گرفت؟

- مبانی بیگ دیتا: درک ۳V (حجم، سرعت، تنوع) و نحوه حل مشکلات دنیای واقعی توسط فناوریهای بیگ دیتا.

- مهندسی و خطوط لوله داده: یادگیری نحوه طراحی گردش کار ETL، دریافت داده از منابع متعدد، تبدیل آن و ذخیره کارآمد آن.

- پردازش بیگ دیتا: کسب تخصص در پردازش دستهای با Apache Spark و جریان بیدرنگ با Kafka و Flink.

- راهکارهای بیگ دیتا مبتنی بر ابر: استقرار و مدیریت راهکارهای بیگ دیتا در Azure و GCP با استفاده از سرویسها.

- پروژههای End-to-End: کار روی پروژههای مرتبط با صنعت، پیادهسازی معماریهای مقیاسپذیر، خطوط لوله داده و تجزیه و تحلیل.

- بهینهسازی عملکرد: درک بهترین شیوهها برای بهینهسازی گردش کار بیگ دیتا برای کارایی و مقیاسپذیری.

این دوره برای چه کسانی مناسب است؟

- مبتدیان و افراد تازهکار: بدون نیاز به تجربه قبلی. سفر خود را در مهندسی بیگ دیتا از صفر شروع کنید.

- توسعهدهندگان نرمافزار: مهارتهای خود را در فناوریهای بیگ دیتا مانند Hadoop، Spark و Kafka گسترش دهید.

- تحلیلگران و دانشمندان داده: کار با مجموعهدادههای بزرگ، خطوط لوله ETL و پردازش بلادرنگ.

- مهندسان ابر و DevOps: یادگیری نحوه استقرار و مدیریت برنامههای بیگ دیتا در محیطهای ابری.

- متخصصان فناوری اطلاعات: با تجربه عملی و پروژههای مرتبط با صنعت، به مهندسی بیگ دیتا انتقال دهید.

پیشنیازها

- دانش پایه کامپیوتر: بدون نیاز به تجربه قبلی در بیگ دیتا.

- پایتون یا SQL (اختیاری): کمک میکند، اما اجباری نیست.

- لپتاپ با 8 گیگابایت رم و دسترسی به اینترنت: برای اجرای ابزارهای بیگ دیتا به صورت محلی یا در ابر.

در پایان این دوره، شما آماده کار، مجهز به مهارتهای عملی و مطمئن در کار با فناوریهای بیگ دیتا مورد استفاده شرکتهای برتر در سراسر جهان خواهید بود.

همین حالا ثبت نام کنید و با بیگ دیتا، شغل خود را به سطح بعدی ببرید.

مقدمه Introduction

-

مروری بر دوره، مهندس بیگ دیتا چه کاری انجام میدهد و نقشه راه Course Overview, what does a Big Data Engineer do & the roadmap

-

نحوه تکمیل دوره و مروری بر پلتفرم Udemy How to Complete Course and Udemy Platform Overview

عملیات اصلی My SQL My SQL Basic Operations

-

ایجاد پایگاه داده، ایجاد جدول، حذف جدول و حذف پایگاه داده در MySQL MySQL Create Database,Create Table,Drop Table And Drop Database

-

تمرین و سوالات تمرینی با راه حل Excercise And Practise Questions With Solution

My SQL-زبان دستکاری داده و تغییر جدول My SQL-Data Manipulation Language And Table Alteration

-

My SQL- کوئری های Null، Update و Delete DML My SQL- Null,UpdateAnd Delete DML queries

-

My SQL- تغییر جدول My SQL- Alter Table

-

سوالات تمرینی دستکاری داده Data Maniplulation Practise Questions

MySQL- انواع مختلف محدودیت ها MySQL- Different Types Of Constraints

-

1-محدودیت های MySQL- کلید اصلی، کلید خارجی، منحصر به فرد، محدودیت های Not Null 1-MySQL Constraints-Primary Key,Foreign Key,Unique,Not Null Constraints

-

MYSQL Constraint- پیش فرض، ایندکس، کلیدهای کاندید MYSQL Constraint- Default, Index,Candidate Keys

-

ویدیوهای بیشتر در مورد MySQL More Videos On MySQL

مبانی پایتون Python Fundamentals

-

شروع کار با پایتون Getting Started with Python

-

نصب Anaconda و VS Code برای پایتون Anaconda And VS Code Installation For Python

-

شروع کار با VS Code و محیط Getting Started With VS Code And Environment

-

مبانی پایتون - نحو و معناشناسی Python Basics-Syntax and Semantics

-

متغیرها در پایتون Variables In Python

-

انواع داده پایه Basics Data Types

-

عملگرها در پایتون Operators In Python

-

عبارات شرطی در پایتون Conditional Statements In Python

-

حلقه ها در پایتون Loops In Python

-

لیست در پایتون List In Python

-

مثال های عملی لیست Practical Examples Of List

-

مجموعه ها در پایتون Sets In Python

-

تاپل ها در پایتون Tuples In Python

-

دیکشنری ها در پایتون Dictionaries In Python

-

توابع در پایتون Functions In Python

-

مثال های توابع پایتون Python Function Examples

-

توابع Lambda در پایتون Lambda Functions In Python

-

توابع Map در پایتون Map functions In Python

-

تابع Filter پایتون Python Filter Function

-

وارد کردن ماژول ها و پکیج ها در پایتون Import Modules And Packages In Python

-

مروری بر کتابخانه استاندارد Standard Library Overview

-

عملیات فایل در پایتون File Operation In Python

-

کار با مسیرهای فایل Working With File Paths

-

مدیریت خطا در پایتون Exception Handling In Python

-

برنامه نویسی شی گرا در پایتون OOPS In Python

-

وراثت در پایتون Inheritance In Python

-

چندریختی در پایتون Polymorphism In Python

-

کپسوله سازی در پایتون Encapsulation In Python

-

انتزاع در پایتون Abstraction In Python

-

متدهای Magic در پایتون Magic Methods In Python

-

Exception سفارشی در پایتون Custom Exception In Python

-

Operator OverLoading در پایتون Operator OverLoading In Python

-

Iterators در پایتون Iterators In Python

-

Generators در پایتون Generators In Python

-

Decorators در پایتون Decorators In Python

-

کار با Numpy در پایتون Working With Numpy In Python

-

Pandas DataFrame و Series Pandas DataFrame And Series

-

دستکاری و تحلیل داده Data Manipulation And Analysis

-

خواندن منبع داده Data Source Reading

کار با پایگاه های داده و پایتون Working With Databases and Python

-

پایتون با Sqllite Python With Sqllite

Logging در پایتون Logging In Python

-

Logging در پایتون Logging In Python

-

Logging با Loggers متعدد Logging With Multiple Loggers

-

Logging در مثال های دنیای واقعی Logging In a Real World Examples

-

پایان پایتون Python Outro

پیش نیازها آموزش های My SQL Prerequisites My SQL Tutorials

-

مقدمه بخش SQL SQL Section Intro

-

آموزش های MySQL مقدماتی تا متوسط Basic To Intermediate MySQL Tutorials

مقدمه ای بر بیگ دیتا Introduction To Big Data

-

مقدمه بخش Section Intro

-

1. بیگ دیتا چیست - یک مثال عملی. 1. What is Big Data - A Practical Example.

-

5 V های بیگ دیتا 5 V's of Big Data

-

بیگ دیتا و سیستم های توزیع شده Big Data and Distributed Systems

-

طراحی یک سیستم بیگ دیتای خوب Designing a Good Big Data System

-

زیرساخت On-Premise در مقابل راه حل های Cloud On-Premise Infra vs Cloud Solutions

-

پایگاه داده در مقابل Data Warehouse در مقابل Data Lake Data base vs Data Warehouse vs Data Lake

-

ETL در مقابل ELT ETL vs ELT

-

مهندس داده چه کاری انجام می دهد و بیگ دیتا در کجا قرار می گیرد؟ What does a Data engineer do & Where Big Data Fit in ?

معماری Hadoop Hadoop Architecture

-

مقدمه بخش Section Intro

-

معرفی Hadoop Introduction To Hadoop

-

ویژگی های Hadoop Properties of Hadoop

-

اکوسیستم Hadoop - اجزای اصلی Hadoop Ecosystem - Main Components

-

اکوسیستم Hadoop - اجزاء Hadoop Ecosystem - Components

معماری HDFS HDFS Architecture

-

معرفی HDFS و اصطلاحات رایج Intro to HDFS and Common Terminology

-

چرا HDFS Why HDFS

-

معماری HDFS HDFS Architecture

-

بلوک ها در HDFS Blocks In HDFS

-

فاکتور Replication در HDFS Replication Factor in HDFS

-

Rack Awareness در HDFS Rack Awareness in HDFS

-

Node Failure Node Failure

-

ایجاد حساب GCP Create GCP Account

Hadoop Data Proc Cluster در Google Cloud Hadoop Data Proc Cluster on Google Cloud

-

Data Node Failure - موقت Data Node Failure - Temporary

-

Data Node Failure - دائمی Data Node Failure - Permanent

-

Secondary Name Node Secondary Name Node

-

Standby Name Node Standby Name Node

-

معماری Hadoop HA Hadoop HA Architecture

-

Data Write در HDFS Data Write in HDFS

-

Read Request در HDFS Read Request in HDFS

Google Cloud Platform و Hadoop Google Cloud Platform & Hadoop

-

ایجاد خوشه GCP Hadoop GCP Hadoop Cluster Creation

-

کاوش خوشه Hadoop خود Exploring our Hadoop Cluster

-

بهترین شیوه ها برای خوشه GCP GCP Cluster Best Practices

-

دستورات لینوکس -1 Linux Commands -1

-

دستورات لینوکس -2 Linux Commands -2

-

دستورات HDFS HDFS Commands

-

پایان Hadoop Hadoop Outro

Map Reduce Map Reduce

-

معرفی Map Reduce Map Reduce Intro

-

معرفی پردازش توزیع شده Intro To Distributed Processing

-

مقدمه Map Reduce Map Reduce Introduction

-

Map Reduce و Cluster Map Reduce & Cluster

-

بخش عملی Map Reduce قسمت 1 Map reduce Practical Part 1

-

MR مثال قسمت 2 MR Example Part 2

-

MR عملی با 1 reducer MR Practical with 1 reducer

-

MR با 2 Reducer عملی MR with 2 Reducer Practical

-

Combiner در MR Combiner in MR

-

Map Reduce با 0 Reducer Map Reduce with 0 Reducer

-

MR روی فایل لاگ بزرگ MR on Big Log File

-

Input Split در MR Input Split in MR

-

پایان Map Reduce Map Reduce Outro

YARN YARN

-

معرفی بخش YARN YARN Section Intro

-

معرفی YARN YARN Introduction

-

اجزای YARN Components of YARN

-

قیاس YARN YARN Analogy

-

فرآیند YARN گام به گام YARN Process Step by step

تابع مرتبه بالاتر، Lambda، Map و Filter در پایتون (بازبینی) Higher Order Function, Lambda, Map and Filter in Python (Revise)

-

توابع مرتبه بالاتر Higher Order Functions

-

توابع Lambda Lambda Functions

-

Map، Filter و Reduce Map, Filter and Reduce

Apache Spark Apache Spark

-

معرفی بخش Spark Spark Section Intro

-

معرفی Spark Spark Introduction

-

سوالات متداول Spark Spark Common questions

-

محدودیت های MR Limitations of MR

-

Spark چیست و ویژگی های آن What is Spark and Its Features

-

اکوسیستم Spark Spark Ecosystem

-

اجرای کد در Spark Executing Code In Spark

-

برنامه Word Count در Spark Word Count Program in Spark

-

راه های اجرای Spark Ways to run Spark

-

Transformation در مقابل Action Transformation vs Action

-

چرا Spark تنبل است Why Is Spark Lazy

Spark Core API - RDD Spark Core API - RDD

-

Spark RDD چیست What is Spark RDD

-

Spark چگونه داده ها را می خواند How Spark reads the data

-

Spark خواندن داده ها و پارتیشن بندی Spark Read Data and Partitioning

-

تولید داده + مراحل پروژه Data Generation + Project Steps

-

عملیات Spark RDD - قسمت 1 Spark RDD Operations - Part 1

-

عملیات Spark RDD - 2 Spark RDD Operations - 2

-

Transformation - Narrow در مقابل Wide Transformation - Narrow vs Wide

-

Jobs Stages و Task در Spark UI Jobs Stages and Task in Spark UI

-

GroupByKey در مقابل ReduceByKey قسمت 1 GroupByKey vs ReduceByKey Part 1

-

ReduceByKey در مقابل GroupByKey قسمت 2 ReduceByKey vs GroupByKey Part 2

-

افزایش یا کاهش تعداد پارتیشن ها Increasing or Decreasing the Number of Partitions

-

Repartition در مقابل Coalesce Repartition vs Coalesce

-

API های سطح بالاتر - Dataframe Higher Level APIs - Dataframe

-

API های سطح بالاتر Spark - Spark Tables Spark Higher Level APIs - Spark Tables

Spark Dataframe Spark Dataframe

-

معرفی Spark Dataframe Spark Dataframe Intro

-

DataFrames در Spark DataFrames in Spark

-

DataFrame - خواندن از HDFS DataFrame - Reading from HDFS

-

Spark Read - Transformation یا Action Spark Read - Transformation or Action

-

Schema Enforcement در Spark Schema Enforcement in Spark

-

Read Modes در Spark Read Modes in Spark

-

Write در Spark Write in Spark

-

عملیات Spark Spark Operations

-

مدیریت انواع داده در PySpark Handling Data Types in PySpark

-

مدیریت نوع Date Handling Date Type

Spark Table و Spark SQL Spark Table and Spark SQL

-

معرفی Spark SQL Spark SQL Intro

-

جداول Spark Spark Tables

-

جدول Spark - Temporary Spark Table - Temporary

-

جدول Spark - Global Temporary Spark Table - Global Temporary

-

جداول Spark - Persistent Table Spark Tables - Persistent Table

-

Spark SQL Spark SQL

-

Spark - Managed در مقابل External Table Spark - Managed vs External Table

-

Spark ایجاد DataFrame Spark Creating DataFrame

Caching در Spark Caching In Spark

-

معرفی Spark Caching Spark Caching Intro

-

معرفی Persist و Caching Introduction To Persist and Caching

-

تفاوت بین Persist و Caching Difference Between Persist and Caching

-

برخی سوالات متداول در مورد Caching Some Common Questions about Caching

-

RDD Caching - فایل کوچک RDD Caching - Small File

-

Spark RDD Caching - فایل بزرگ Spark RDD Caching - Big File

-

Caching DF در Spark Caching DF in Spark

-

Caching DF - فایل بزرگ 1 Caching DF - Large File 1

-

Spark DF Caching - قسمت 2 Spark DF Caching - Part 2

-

Spark Table Caching Spark Table Caching

معماری Spark Spark Architecture

-

معرفی معماری Spark Spark Architecture Intro

-

معماری Spark - Run Mode Spark Architecture - Run Mode

-

طبیعت توزیع شده Spark و محاسبات In-Memory Spark's Distributed Nature and In-Memory Computation

-

معماری و اجزای Spark Spark Architecture and Components

-

Spark روی خوشه Standalone Spark on Standalone cluster

-

YARN (بازبینی) - Component of YARN YARN (Revision) - Component of YARN

-

YARN (بازبینی) - فرآیند گام به گام YARN (Revision) - Step by Step Process

-

Yarn روی معماری Spark + UI Yarn on Spark Architecture + UI

-

تفاوت بین Standalone و روی Yarn Difference Between Standalone and on Yarn

-

حالت های Deployment در Spark Deployment Modes in Spark

پروژه 1 Spark - استخراج بینش مشتری و سفارشات Project 1 Spark - Extracting Customer and Orders insight

-

معرفی پروژه های Spark Spark Projects Intro

-

خواندن داده Read Data

-

پردازش داده های مشتری Process Customer Data

-

بینش عملی از مجموعه داده های مشتری و سفارش Actionable Insight from Customer and Order Dataset

پروژه 2 Spark - داده های دنیای واقعی Spark Project 2 - Real World Data

-

تشریح پروژه - مجموعه داده تجارت الکترونیک واقعی Anatomy of Project - Real E-commerce Dataset

-

اکتشاف و درک داده ها Exploration and Understanding Of Data

-

Data Ingestion در Dataproc Cluster Data Ingestion into Dataproc Cluster

-

اکتشاف داده - 1 Data Exploration - 1

-

اکتشاف داده Data Exploration

-

ماژول 2 - Data Cleaning و Transformation Module 2 - Data Cleaning and Transformation

-

Data Cleaning & Transformation Data Cleaning & Transformation

-

ماژول 3 - Data Integration و Aggregation Module 3 - Data Integration and Aggregation

-

Data Integration - اتصال تمام مجموعه داده ها Data Integration - Joining All Datasets

-

Joins بهینه شده Aggregation و Window Function Optimized Joins Aggregation and Window Function

-

Advance Data Aggregations Advance Data Aggregations

-

Advance Enrichment Advance Enrichment

-

ماژول 4 - Spark Configuration Optimization Module 4 - Spark Configuration Optimization

-

استراتژی های بهینه سازی Join Join Optimization Strategies

-

Data Serving Layer Data Serving Layer

Hive Hive

-

معرفی Hive Hive Intro

-

معرفی Hive Introduction To Hive

-

چگونه Hive پردازش بیگ دیتا را آسان تر می کند How Hive makes Big Data Processing Easier

-

برخی سوالات/تصورات غلط متداول در مورد Hive Some Common Questions/Misconceptions about Hive

-

Hive Practical - اتصال به Hive از طریق ترمینال و Beeline Hive Practical - Connecting to Hive via terminal and Beeline

-

Hive Practical 2 - ایجاد و پرس و جو از جدول Hive Practical 2 - Creating and Querying Table

-

دسترسی به Metadata در Hive Accessing Metadata in Hive

-

دسترسی به Hive Metadata (تصحیح صدا) Accessing Hive Metadata ( Audio Corrected)

-

معماری و اجزای Hive Hive Architecture & Components

-

جریان Query Hive Hive Query Flow

-

Derby DB در Hive Derby DB in Hive

Kafka Kafka

-

معرفی Kafka Kafka Intro

-

معرفی Apache Kafka Introduction To Apache Kafka

-

چرا Kafka و موارد استفاده آن Why Kafka and Its Use Cases.mp4

-

معماری Kafka kafka Architecture

-

راه های اجرای Kafka Ways to run Kafka

-

ایجاد یک کلاستر Confluent Kafka (بدون نیاز به CC) Creating a confluent Kafka Cluster (No CC required)

-

تولید پیام به کلاستر Kafka Producing Message to Kafka Cluster

-

Kafka Producers ارسال پیام های متعدد Kafka Producers Send Multiple Messages

-

Callback Poll و Flush Callback Poll and Flush

-

Consuming پیام از Kafka Consuming Message from Kafka

-

Confluent Kafka روی CLI Confluent Kafka on CLI

Docker های کامل مقدماتی تا پیشرفته Complete Basic To Advance Dockers

-

معرفی Docker و Airflow Docker and Airflow Intro

-

معرفی سری Docker Introduction To Docker Series

-

Docker ها و Containers چیست What are Dockers And Containers

-

Docker Images در مقابل Containers Docker Images vs Containers

-

Dockers در مقابل Virtual Machines Dockers vs Virtual Machines

-

نصب Dockers Dockers Installation

-

ایجاد یک Docker Image Creating A Docker Image

-

دستورات اصلی Docker Docker Basic Commands

-

ارسال Docker Image به Docker Hub Push Docker Image To Docker Hub

-

Docker Compose Docker Compose

شروع کار با Airflow Getting Started With Airflow

-

معرفی Apache Airflow Introduction To Apache Airflow

-

اجزای کلیدی Apache Airflow Key Components Of Apache Airflow

-

چرا AirFlow برای بیگ دیتا و MLOPS Why AirFlow For Big Data And MLOPS

-

راه اندازی Airflow با Astro Setting Up Airflow With Astro

-

ساخت اولین DAG خود با Airflow Building Your First DAG With Airflow

-

طراحی DAG محاسبه ریاضی با Airflow Designing Mathematical Calculation DAG With Airflow

-

شروع کار با TaskFlow API با استفاده از Apache Airflow Getting Started With TaskFlow API Using Apache Airflow

خط لوله Airflow ETL با Postgres و API Integration در ASTRO Cloud و AWS Airflow ETL Pipeline with Postgres and API Integration In ASTRO Cloud And AWS

-

معرفی خط لوله ETL Introduction To ETL Pipeline

-

بیانیه مشکل ETL و تنظیم ساختار پروژه ETL Problem Statement And Project Structure Set Up

-

تعریف ETL DAG با اجرای مراحل Defining ETL DAG With Implementing Steps

-

مرحله 1 - تنظیم Postgres و ایجاد Task جدول در Postgres Step 1- Setting Up Postgres And Creating Table Task In Postgres

-

مرحله 2 - یکپارچه سازی NASA API با خط لوله Extract Step 2- NASA API Integration With Extract Pipeline

-

مرحله 3 - ساخت خط لوله Transformation و Load Step 3- Building Transformation And Load Pipeline

-

اجرای نهایی خط لوله ETL با تنظیم اتصال AirFlow ETL Pipeline Final Implementation With AirFlow Connection Set Up

-

استقرار خط لوله ETL در Astro Cloud و AWS ETL Pipeline Deployment In Astro Cloud And AWS

Databricks Databricks

-

معرفی Databricks Databricks Intro

-

Databricks چیست What is Databricks

-

چرا Databricks Why Databricks

-

ایجاد حساب Databricks Community Create Databricks Community Account

-

Databricks UI Walkthrough Databricks UI Walkthrough

-

درک معماری Databricks Understanding Databricks Architecture

-

Databricks File System Databricks File System

Databricks - پروژه Databricks - Project

-

خواندن داده در Databricks Read Data in Databricks

-

پردازش داده در Databricks - داده های مشتری Process Data on Databricks - Customer Data

-

پردازش مشتری با سفارشات - بینش های عملی Processing Customer with Orders - Actionable Insights

Azure Cloud Azure Cloud

-

معرفی Azure Azure Intro

-

ایجاد حساب Azure Creating an Azure Account

-

مروری بر Azure Cloud Azure Cloud Overview

پروژه Azure Cloud قسمت 1 Azure Cloud Project Part 1

-

منابع کامل پروژه Complete Project Resources

-

پیش نیاز Pre-Requisite

-

معماری پروژه Project Architecture

-

ایجاد حساب Azure Creating Azure Account

-

مروری بر Azure Cloud Azure Cloud Overview

-

مروری بر مجموعه داده: مجموعه داده Olist Dataset Overview : Olist Dataset

-

SQL DB و Data Ingestion SQL DB & Data Ingestion

-

Resource و Resource Group در Azure Resource & Resource Group in Azure

-

Azure Data Factory Azure Data Factory

-

ADLS Gen 2 Storage Account ADLS Gen 2 Storage Account

-

مروری بر Medallion Architecture Medallion Architecture Overview

-

Ingestion با Azure Data Factory Ingestion With Azure Data Factory

-

Real Time Ingestion با Azure Data Factory Real Time Ingestion with Azure Data Factory

-

Parametrized Ingestion با ADF Parametrized Ingestion with ADF

-

ایجاد حساب Azure Databricks Azure Databricks Account Creation

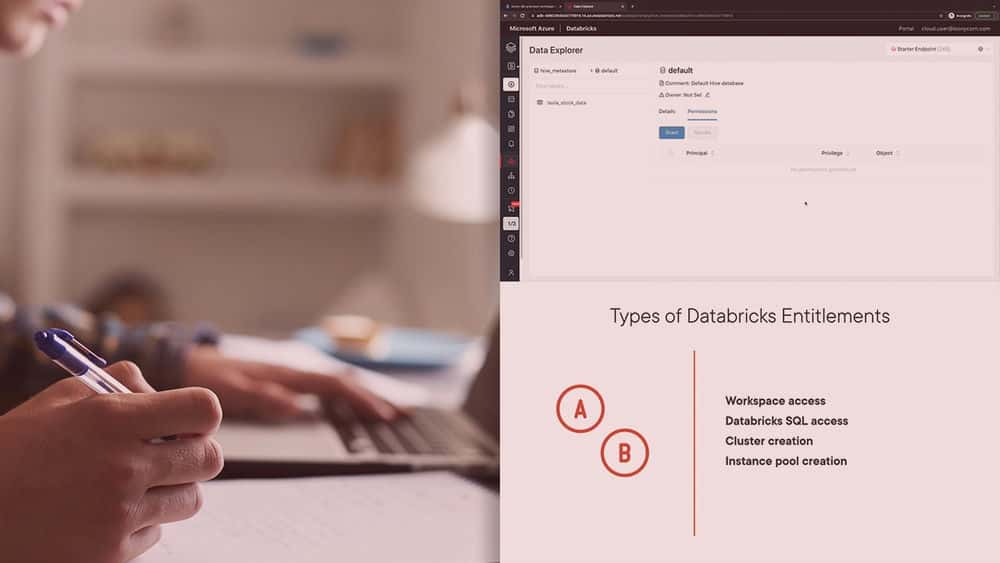

-

مروری بر Azure Databricks Azure Databricks Overview

-

مروری بر رابط کاربری Azure Databricks Azure Databricks UI Overview

-

ایجاد Compute و Notebook Creating Compute and Notebook

-

MongoDB ingestion به Databricks MongoDB ingestion to Databricks

-

مروری بر Azure Databricks Workflow Azure Databricks Workflow Overview

-

اتصال ADLS Gen2 Datalake به Databricks ADLS Gen2 Datalake to Databricks Conenction

-

دسترسی به ADLS Gen2 Data Accessing ADLS Gen2 Data

پروژه Azure Cloud قسمت 2 Azure Cloud Project Part 2

-

بازبینی سریع Quick Revision

-

غنی سازی داده Data Enrichment

-

دسترسی به داده در Databricks Accessing Data in Databricks

-

خواندن داده در Databricks Read Data in Databricks

-

Spark Transformation Spark Transformation

-

Mongo DB data برای Enrichment Mongo DB data for Enrichment

-

پاکسازی داده Data Cleaning

-

استخراج بینش از داده ها Extracting Insights from Data

-

Spark - Transformation در مقابل Action Spark - Transformation vs Action

-

اتصال داده Joining Data

-

غنی سازی داده از طریق MongoDB Enriching Data via MongoDB

-

تجسم داده در Databricks Visualizing Data in Databricks

-

صادر کردن داده به Silver Layer Exporting Data to Silver Layer

-

مروری بر Azure Synapse و ایجاد حساب Azure Synapse Overview and Account Creation

-

مروری بر رابط کاربری Synapse Synapse UI Overview

-

دسترسی Synapse به Lake Synapse To Lake Access

-

SQL Pool - Dedicated در مقابل Serverless SQL Pool - Dedicated vs Serverless

-

دسترسی به Lake Data Access Lake Data

-

ایجاد Gold View و Schema Create Gold View and Schema

-

Azure Synapse Workflow Azure Synapse Workflow

-

درک CETAS CETAS Understanding

-

ایجاد External Serving Table در Gold Create External Serving Table in Gold

-

Serving Layer تکمیل شد :) Serving Layer Completed :)

-

جریان تجسم Visualization Flow

-

تشکر و تبریک به خاطر تکمیل یک پروژه در سطح صنعت Thank you and Congratulations on completing an industry level Project

https://donyad.com/d/273d86

Krish Naik

Krish Naik

مهندس ارشد هوش مصنوعی

KRISHAI Technologies Private Limited

KRISHAI Technologies Private Limited

مهندس هوش مصنوعی و یادگیری ماشین

Mayank Aggarwal

Mayank Aggarwal

MLE ارشد

نمایش نظرات