آموزش پروژه پایان به پایان Azure Databricks با Unity Catalog CICD - آخرین آپدیت

Azure Databricks end to end project with Unity Catalog CICD

با دوره جامع Udemy ما برای تسلط بر Azure Databricks، سفری تحولآفرین را آغاز کنید. این دوره نه فقط برای یادگیری، بلکه برای تجهیز شما به مفاهیم کاربردی ضروری برای گذراندن گواهینامه Databricks Certified Data Engineer Associate، کلید موفقیت شماست.

در پروژههای دنیای واقعی غوطهور شوید که در آن از قابلیتهای Unity Catalog، Delta Lake، و متدولوژیهای CI/CD استفاده میکنید، همگی در حین اجرای معماری مدالیون پیشرفته. این برنامه آموزشی به عنوان دروازه شما برای ادغام و پردازش یکپارچه داده ها در فضای ابری عمل می کند و بینش ارزشمندی را در مورد آخرین شیوه های مهندسی داده ارائه می دهد.

در طول دوره، به پیچیدگیهای دریاچه دلتا بپردازید، مهارتهای خود را با Unity Catalog اصلاح کنید، و در هنر ادغام مداوم و استقرار مداوم مهارت کسب کنید. چه یک متخصص داده باتجربه با هدف ارتقاء مجموعه مهارت های خود باشید یا یک مشتاق نوظهور مشتاق کشف دنیای مهندسی داده، این دوره ابزارها و دانشی را برای ارتقای تخصص شما در Azure Databricks فراهم می کند.

در این سفر آموزشی به ما بپیوندید تا پتانسیل کامل مهندسی داده مبتنی بر ابر را باز کنید و خودتان را به سمت موفقیت در پروژههای داده معاصر سوق دهید. حرفه و دانش خود را با این دوره جامع Udemy غنی کنید و تضمین کنید که فرصت تبدیل شدن به یک مهندس ماهر Azure Databricks را از دست ندهید. تحول شما از اینجا شروع می شود!

معرفی Introduction

-

معرفی دوره Course Introduction

-

معماری و مفاهیم پروژه Project Architecture and Concepts

-

پیش نیازها و مزایای دوره Course prerequisites and benefits

-

کد کامل پروژه Project Complete Code

-

وارد کردن کد پروژه به فضای کاری Databricks Importing project code into Databricks workspace

راه اندازی محیط Environment Setup

-

بخش مقدمه Section Introduction

-

ایجاد بودجه برای پروژه Creating a budget for project

-

ایجاد یک فضای کاری Azure Databricks Creating an Azure Databricks Workspace

-

ایجاد Azure Datalake Storage Gen2 Creating an Azure Datalake Storage Gen2

-

اگرچه در مورد رابط کاربری فضای کاری دیتابریکس Walkthough on databricks Workspace UI

Azure Databricks - مقدمه Azure Databricks - An Introduction

-

بخش مقدمه Section Introduction

-

مقدمه ای بر پردازش داده های توزیع شده Introduction to Distributed Data Processing

-

Azure Databricks چیست؟ What is Azure Databricks

-

Azure Databricks Architecture Azure Databricks Architecture

-

انواع خوشه و پیکربندی Cluster types and configuration

-

پشت صحنه هنگام ایجاد خوشه Behind the scenes when creating cluster

-

برای Databricks Community Edition ثبت نام کنید Sign up for Databricks Community Edition

-

آشنایی با مبانی نوت بوک و Markdown Understanding notebook and Markdown basics

-

نوت بوک - دستورات جادویی Notebook - Magic Commands

-

DBUitls - ابزارهای سیستم فایل DBUitls -File System Utilities

-

DBUitls - ابزارک Utilities DBUitls -Widget Utilities

-

DBUtils - نرم افزار نوت بوک DBUtils - Notebook Utils

-

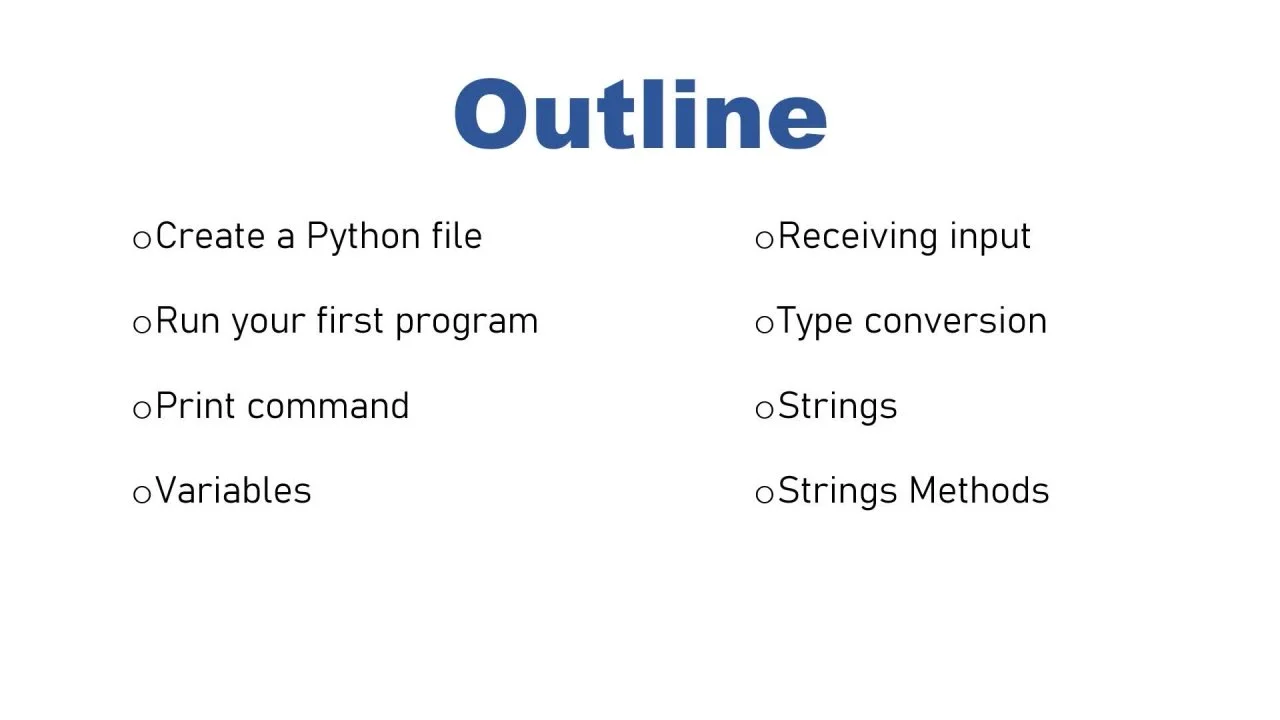

دانش اولیه در مورد آجرهای داده Azure Basic knowledge on Azure databricks

دریاچه دلتا Delta lake

-

بخش معرفی Section Intro

-

معایب Azure Datalake Drawbacks of Azure Datalake

-

دریاچه دلتا چیست؟ What is delta lake

-

آشنایی با معماری لیک هاوس Understanding Lakehouse Architecture

-

ایجاد فضای کاری آجرهای داده و ADLS برای دریاچه دلتا Creating databricks workspace and ADLS for delta lake

-

دسترسی به فضای ذخیره سازی Datalake با استفاده از سرویس اصلی Accessing Datalake storage using service principal

-

معایب ADLS - عملی Drawbacks of ADLS - practical

-

ایجاد دریاچه دلتا Creating Delta lake

-

درک قالب دلتا Understanding the delta format

-

درک گزارش معاملات Understanding Transaction Log

-

ایجاد جداول دلتا با استفاده از دستور SQL Creating delta tables using SQL Command

-

ایجاد جدول دلتا با استفاده از کد PySpark Creating Delta table using PySpark Code

-

آپلود فایل برای سخنرانی های بعدی Uploading files for next lectures

-

اجرای طرحواره Schema Enforcement

-

تکامل طرحواره Schema Evolution

-

سفر در زمان و نسخه سازی Time Travel and Versioning

-

فرمان خلاء Vacuum Command

-

تبدیل به دلتا Convert to Delta

-

درک دستور Optimize - نسخه ی نمایشی Understanding Optimize Command - Demo

-

بهینه سازی فرمان - عملی Optimize Command - Practical

-

UPSERT با استفاده از MERGE UPSERT using MERGE

-

دانش دریاچه دلتا خود را آزمایش کنید Test your Delta lake knowledge

کاتالوگ یونیتی Unity Catalog

-

بخش مقدمه Section Introduction

-

Unity Catalog چیست؟ What is Unity Catalog

-

ایجاد Access Connector برای Databricks Creating Access Connector for Databricks

-

ایجاد متاستور در کاتالوگ یونیتی Creating Metastore in Unity Catalog

-

مدل شیء کاتالوگ یونیتی Unity Catalog Object Model

-

نقش ها در کاتالوگ یونیتی Roles in Unity Catalog

-

ایجاد کاربر در Azure Entra ID Creating users in Azure Entra ID

-

مدیریت کاربران و گروه ها عملی است User and groups management Practical

-

سیاست های خوشه ای Cluster Policies

-

استخرهای خوشه ای چیست؟ What are cluster pools

-

ایجاد Cluster Pool Creating Cluster Pool

-

ایجاد کاتالوگ Dev Creating a Dev Catalog

-

امتیازات کاتالوگ یونیتی Unity Catalog Privileges

-

آشنایی با کاتالوگ یونیتی Understanding Unity Catalog

-

ایجاد و دسترسی به موقعیت مکانی خارجی و اعتبار ذخیره سازی Creating and accessing External location and storage credentials

-

جداول مدیریت شده و خارجی در کاتالوگ یونیتی Managed and External Tables in Unity Catalog

-

دانش خود را در مورد Unity Catalog بررسی کنید Check your knowledge on Unity Catalog

جریان ساختار یافته جرقه Spark Structured Streaming

-

بخش مقدمه Section Introduction

-

جریان ساختار یافته جرقه - اصول اولیه Spark Structured Streaming - basics

-

درک میکرو دسته ها و پرس و جو پس زمینه Understanding micro batches and background query

-

منابع و سینک های پشتیبانی شده Supported Sources and Sinks

-

WriteStream و نقاط بازرسی WriteStream and checkpoints

-

پایگاه داده های نسخه Community را رها کنید Community Edition Drop databases

-

درک حالت های خروجی Understanding outputModes

-

درک محرک ها Understanding Triggers

-

Autoloader - مقدمه Autoloader - Intro

-

Autoloader - استنتاج طرحواره Autoloader - Schema inference

-

طرحواره تکامل - نسخه ی نمایشی Schema Evolution - Demo

-

تکامل طرحواره - عملی Schema Evolution - Practical

-

دانش خود را در مورد استریمینگ بررسی کنید Check your knowledge on Streaming

بررسی اجمالی پروژه Project Overview

-

بخش مقدمه Section Introduction

-

معماری مدالیون معمولی Typical Medallion Architecture

-

معماری پروژه Project Architecture

-

درک مجموعه داده Understanding the dataset

راه اندازی پروژه Project Setup

-

بخش مقدمه Section Introduction

-

راه اندازی مورد انتظار Expected Setup

-

ایجاد کانتینرها و مکان های خارجی Creating containers and External Locations

-

ایجاد تمام طرحواره ها به صورت پویا Creating all schemas dynamically

-

ایجاد جداول برنزی به صورت پویا Creating bronze Tables Dynamically

بلع تا برنز Ingestion to Bronze

-

بخش مقدمه Section Introduction

-

بلع داده ها به لایه برنز - نسخه نمایشی Ingesting data to bronze layer - Demo

-

دریافت دادههای raw_traffic به جدول برنزی Ingesting raw_traffic data to bronze table

-

تکلیف برای دریافت داده های raw_roads به جدول برنزی Assignment to get the raw_roads data to bronze table

-

دریافت دادههای raw_roads به جدول برنزی Ingesting raw_roads data to bronze Table

-

برای اثبات بارگذاری خودکار، بارگذاری افزایشی را کنترل می کند To prove autoloader handles incremental loading

تبدیل لایه نقره ای Silver Layer Transformations

-

بخش مقدمه Section Introduction

-

تبدیل داده های ترافیک نقره ای Transforming Silver Traffic data

-

برای اثبات تنها رکوردهای افزایشی در حال تغییر هستند To prove only incremented records were being transformed

-

ایجاد یک نوت بوک مشترک Creating a common Notebook

-

یک نوت بوک را از نوت بوک دیگر اجرا کنید Run one notebook from another notebook

-

تبدیل داده های جاده های نقره ای Transforming Silver Roads data

در حال بارگذاری در لایه طلا Loading to Gold Layer

-

بخش مقدمه Section Introduction

-

دریافت داده ها به لایه طلایی Getting data to Gold Layer

-

تبدیل لایه طلا و بارگذاری Gold Layer Transformations and loading

ارکستراسیون با گردش کار Orchestrating with Workflows

-

بخش مقدمه Section Introduction

-

اضافه کردن run برای نوت بوک رایج در همه نوت بوک ها Adding run for common notebook in all notebooks

-

ایجاد مشاغل و اجرای جریان از انتها به پایان Creating Jobs and executing end to end flow

-

اتصال ماشه به گردش کار Attaching trigger to workflows

گزارش با Power BI Reporting with Power BI

-

نصب Power BI Desktop Installing Power BI Desktop

-

گزارش داده ها به Power BI Reporting data to Power BI

یکپارچه سازی مداوم و استقرار مستمر (CICD) Continuous Integration and Continuous Deployment (CICD)

-

بخش مقدمه Section Introduction

-

راه اندازی مورد انتظار Expected Setup

-

درک یکپارچگی مداوم Understanding Continuous Integration

-

درک استقرار مداوم Understanding Continuous Deployment

-

ایجاد منابع مورد نیاز برای UAT Creating Required resources for UAT

-

پیکربندی ظروف ذخیره سازی و مکان های خارجی برای UAT Configuring storage containers and external locations for UAT

-

وارد شوید و در Azure DevOps مخزن ایجاد کنید Login and create repository in Azure DevOps

-

ادغام Azure Devops با Databricks Integrating Azure Devops with Databricks

-

ایجاد شاخه ویژگی و درخواست کشش به شاخه اصلی Creating feature branch and pull request to main branch

-

ایجاد درخواست کشش به عنوان کاربر جدید Creating pull request as new user

-

بارگذاری و درک فایل های YAML برای CICD Uploading and understanding YAML Files for CICD

-

ایجاد خط لوله CI برای داشتن پوشه زنده Creating CI pipeline to have live folder

-

مجوزهای دیدن پوشه زنده Permissions to see Live Folder

-

ایجاد خط لوله استقرار و استقرار Creating Deployment pipeline and deploying

-

آزمایش انتها به انتها خط لوله CICD End to end test CICD pipeline

-

اجرای نوت بوک در UAT Running notebooks in UAT

جداول زنده دلتا (DLT) Delta Live Tables (DLT)

-

بخش معرفی Section Intro

-

منشاء جداول زنده دلتا Origin of Delta live tables

-

ملاحظات در معماری لیک هاوس Considerations in Lakehouse Architecture

-

درک ETL اعلامی Understanding Declarative ETL

-

محدودیت های جداول زنده دلتا Limitations of Delta Live Tables

-

تعریف جداول از مجموعه داده ها Defining Tables from datasets

-

ایجاد خط لوله DLT Creating DLT Pipeline

-

خط لوله DLT از انتها به انتها End to end DLT Pipeline

-

حذف خوشه توسط خط لوله DLT Deleting cluster by DLT pipeline

نتیجه Conclusion

-

اتمام دوره Course completion

-

سایر دوره های مهندسی داده من My other Data Engineering Courses

https://donyad.com/d/13b92f

Shanmukh Sattiraju

Shanmukh Sattiraju

مهندس داده لاجورد

نمایش نظرات