آموزش Apache Spark 3 Fundamentals - آخرین آپدیت

Apache Spark 3 Fundamentals

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیوها:

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

تریلر دوره Course Trailer

شروع کار با آپاچی اسپارک Getting Started with Apache Spark

-

مقدمه و رئوس مطالب دوره Introduction and Course Outline

-

بررسی نسخه Version Check

-

نیاز به اسپارک آپاچی Need for Apache Spark

-

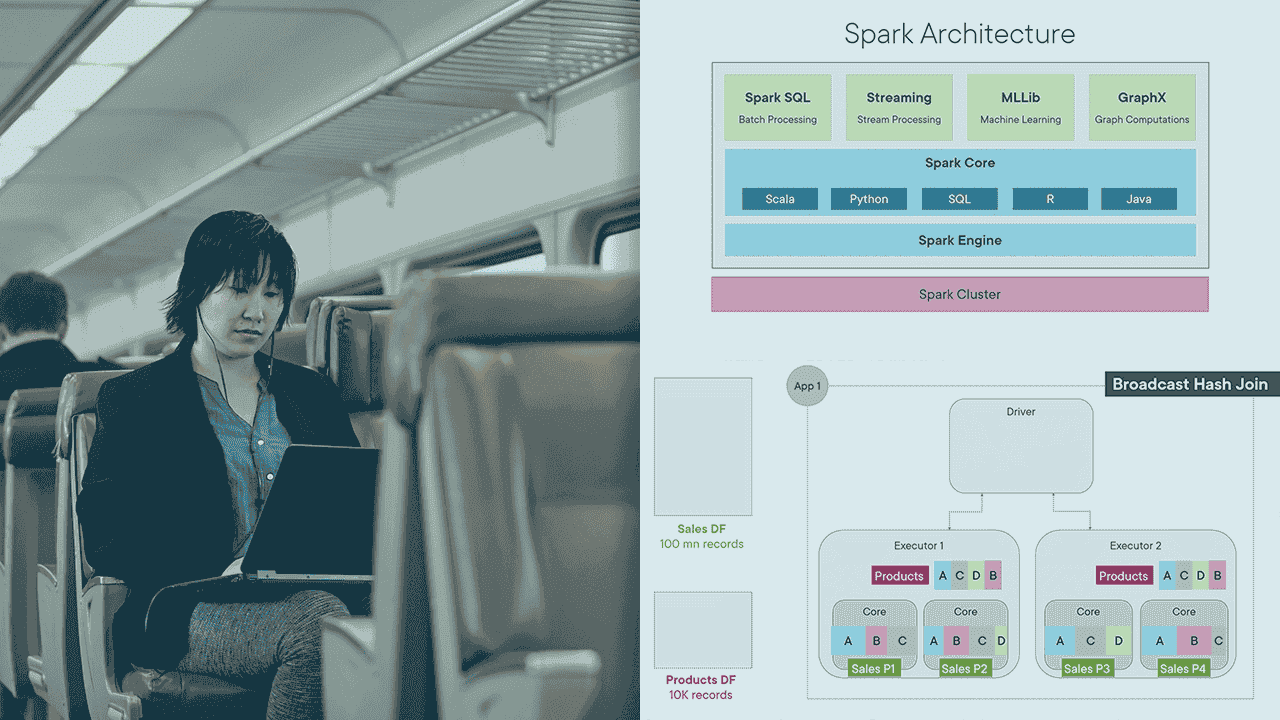

درک معماری اسپارک و اکوسیستم Understanding Spark Architecture and Ecosystem

-

چگونه اعدام در اسپارک اتفاق می افتد؟ How Execution Happens in Spark?

-

Spark API - RDD ها، DataFrames و Datasets Spark APIs – RDDs, DataFrames and Datasets

-

خلاصه Summary

راه اندازی Spark Environment Setting up Spark Environment

-

نمای کلی ماژول Module Overview

-

درک محیط های اسپارک Understanding Spark Environments

-

نصب اسپارک Installing Spark

-

نظارت بر Spark با رابط کاربری وب Monitoring Spark with Web UI

-

گزینه 1: اجرای Spark در خط فرمان Option 1: Running Spark in Command Line

-

گزینه 2: اجرای اسپارک با نوت بوک های Jupyter Option 2: Running Spark with Jupyter Notebooks

-

گزینه 3: ایجاد پروژه با PyCharm IDE Option 3: Creating Project with PyCharm IDE

-

گزینه 4: اجرای مشاغل با Spark Submit Option 4: Running Jobs with Spark Submit

-

راه اندازی خوشه چند گره Setting Up Multi-Node Cluster

-

خلاصه Summary

کار با RDDs - Resilient Distributed Datasets Working with RDDs - Resilient Distributed Datasets

-

نمای کلی ماژول Module Overview

-

درک RDD ها Understanding RDDs

-

ایجاد RDD Creating RDDs

-

کار با جفت RDD Working with Pair RDDs

-

اعمال عملیات بر روی RDD ها Applying Operations on RDDs

-

استفاده از تبدیل های باریک Using Narrow Transformations

-

تحولات گسترده و درهم ریختن داده ها Wide Transformations and Data Shuffling

-

مفاهیم کاربردی Spark: مشاغل، مراحل و وظایف Spark Application Concepts: Jobs, Stages and Tasks

-

خلاصه Summary

تمیز کردن و تبدیل داده ها با DataFrames Cleaning and Transforming Data with DataFrames

-

نمای کلی ماژول Module Overview

-

آشنایی با DataFrames Understanding DataFrames

-

ایجاد DataFrames Creating DataFrames

-

اعمال طرحواره ها Applying Schemas

-

تجزیه و تحلیل و پاکسازی داده ها Analyzing and Cleaning Data

-

اعمال تحولات Applying Transformations

-

مدیریت داده های فاسد Handling Corrupt Data

-

ذخیره داده های پردازش شده در فایل ها Saving Processed Data to Files

-

خلاصه Summary

کار با Spark SQL، UDF و عملیات Common DataFrame Working with Spark SQL, UDFs, and Common DataFrame Operations

-

نمای کلی ماژول Module Overview

-

اجرای پرس و جوهای SQL روی DataFrames Running SQL Queries on DataFrames

-

کار با Spark Tables Working with Spark Tables

-

کار با توابع تعریف شده توسط کاربر (UDF) Working with User Defined Functions (UDFs)

-

انجام عملیات بر روی مجموعه داده های متعدد Performing Operations on Multiple Datasets

-

انجام عملیات پنجره Performing Window Operations

-

خلاصه Summary

انجام بهینه سازی ها در Spark Performing Optimizations in Spark

-

نمای کلی ماژول Module Overview

-

کار با پارتیشن اسپارک Working with Spark Partitions

-

تغییر پارتیشن های DataFrame Changing DataFrame Partitions

-

مدیریت حافظه Memory Management

-

داده های ماندگار Persisting Data

-

استراتژی های پیوستن اسپارک و پیوستن به پخش Spark Join Strategies and Broadcast Joins

-

بهینه سازی مرتب سازی ترکیبی با Bucketing بپیوندید Optimizing Shuffle Sort Join with Bucketing

-

تخصیص دینامیک منابع Dynamic Resource Allocation

-

تخصیص منابع با استفاده از برنامه ریزی منصفانه Resource Allocation Using Fair Scheduling

-

خلاصه Summary

ویژگی های Apache Spark 3 Features in Apache Spark 3

-

مقدمه ای بر آپاچی اسپارک 3 Introduction to Apache Spark 3

-

اجرای پرس و جو تطبیقی: ادغام پویا Adaptive Query Execution: Dynamic Coalescing

-

اجرای پرس و جو تطبیقی: پیوستن پویا Adaptive Query Execution: Dynamic Join

-

اجرای پرس و جو تطبیقی: مدیریت انحراف Adaptive Query Execution: Handling Skew

-

هرس پارتیشن دینامیک Dynamic Partition Pruning

-

خلاصه Summary

ساخت دریاچه داده های قابل اعتماد با اسپارک و دریاچه دلتا Building Reliable Data Lake with Spark and Delta Lake

-

نمای کلی ماژول Module Overview

-

نیاز به دریاچه دلتا با اسپارک Need for Delta Lake with Spark

-

دریاچه دلتا چگونه کار می کند؟ How Delta Lake Works?

-

ضمانت اسید در دریاچه دلتا ACID Guarantees on Delta Lake

-

ایجاد جداول دلتا Creating Delta Tables

-

درج داده ها به جدول دلتا Inserting Data to Delta Table

-

انجام عملیات DML Performing DML Operations

-

اعمال محدودیت های جدول Applying Table Constraints

-

دسترسی به داده ها با سفر در زمان Accessing Data with Time Travel

-

خلاصه Summary

مدیریت داده های جریانی با جریان ساختاری Spark Handling Streaming Data with Spark Structured Streaming

-

نمای کلی ماژول Module Overview

-

درک جریان در Spark Understanding Streaming in Spark

-

مدل پردازش جریان ساختاریافته Structured Streaming Processing Model

-

استخراج داده های جریانی از منبع Extracting Streaming Data from Source

-

تبدیل و بارگذاری داده ها Transforming and Loading Data

-

خلاصه Summary

کار با Spark در Cloud Working with Spark in Cloud

-

نمای کلی ماژول Module Overview

-

استفاده از Spark در Databricks Using Spark in Databricks

-

استفاده از Spark در Azure Synapse Analytics Using Spark in Azure Synapse Analytics

-

خلاصه Summary

https://donyad.com/d/8e2bc6

Mohit Batra

Mohit Batra

موهیت یک مهندس داده ، یک مربی مجوز مایکروسافت (MCT) و یک مشاور است. موهیت دارای بیش از 15 سال تجربه گسترده در زمینه راهکارهای مقیاس بزرگ هوش تجاری ، ذخیره سازی داده ها و راه حل های بزرگ داده با شرکت هایی مانند مایکروسافت و برخی از بانک های پیشرو سرمایه گذاری است. موهیت به عنوان یک متخصص در زمینه خود ، اغلب دانش خود را در Azure ، Spark ، SQL Server و Power BI در تالارهای گفتگوی عمومی مختلف و به عنوان یک مربی شریک کرده است. محیط واقعاً عاشق تدریس است و از تولید مواد یادگیری جذاب و با کیفیت برای جلسات خود لذت می برد. در اوقات فراغت ، موهیت عاشق کتاب خواندن است ، از عکاسی و موسیقی لذت می برد.

نمایش نظرات