آموزش استخراج داده های ساخت یافته از وب با استفاده از Scrap - آخرین آپدیت

Extracting Structured Data from the Web Using Scrapy

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیویی برای نمایش وجود ندارد.

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

شروع به تراشیدن سایت های وب با استفاده از اسکرپی Getting Started Scraping Web Sites Using Scrapy

-

بررسی اجمالی ماژول Module Overview

-

پیش نیازها و طرح کلی دوره Prerequisites and Course Outline

-

معرفی اسکرپی Introducing Scrapy

-

Scrap را نصب و تنظیم کنید Install and Set Up Scrapy

-

پوسته اسكراپی The Scrapy Shell

-

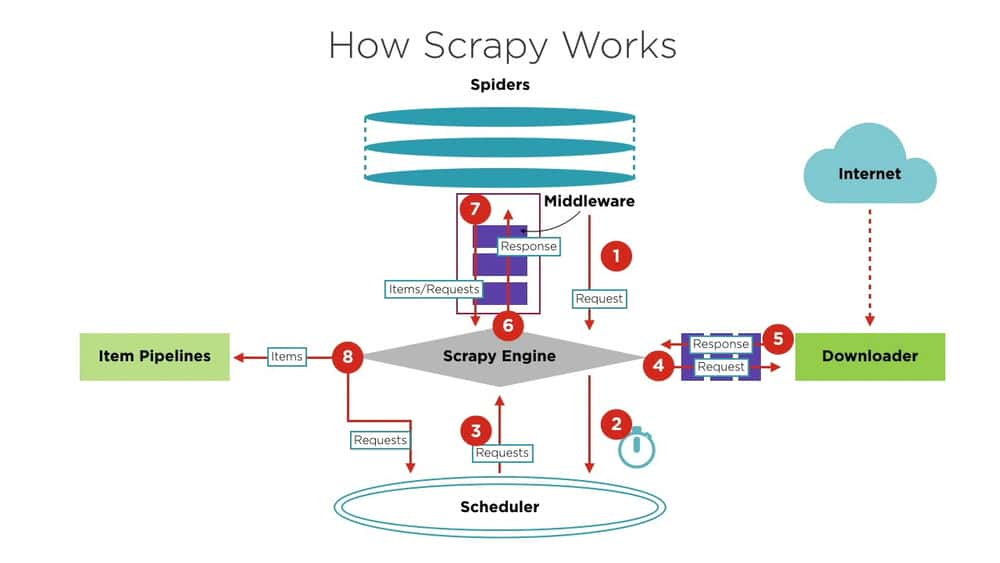

بررسی اجمالی معماری Architecture Overview

-

انتخابگرها با استفاده از کلاس های CSS Selectors Using CSS Classes

-

انتخابگرها با استفاده از XPath Selectors Using XPath

-

استفاده از عبارات منظم با انتخابگرها Using Regular Expressions with Selectors

استفاده از عنکبوت برای خزیدن سایتها Using Spiders to Crawl Sites

-

بررسی اجمالی Overview

-

معرفی عنکبوت ها Introducing Spiders

-

در حال اجرا عنکبوت ها برای خزیدن وب سایت ها Running Spiders to Crawl Websites

-

استفاده از Crawl Spiders برای دنبال کردن پیوندها Using Crawl Spiders to Follow Links

-

تعیین قوانین استخراج پیوند برای Crawl Spiders Specifying Link Extraction Rules for Crawl Spiders

-

خزیدن فایلهای CSV Crawling CSV Files

-

معرفی Nested Selectors Introducing Nested Selectors

-

استفاده از موارد برای ذخیره داده های ساخت یافته Using Items to Store Structured Data

-

استفاده از موارد با عنکبوت Using Items with Spiders

-

پردازنده های ورودی Input Processors

-

لودرهای مورد Item Loaders

-

خطوط لوله مورد Item Pipelines

-

استفاده از صادرکنندگان خوراک برای ذخیره در پرونده Using Feed Exporters to Save to a File

-

انداختن وسایل تراشیده شده Dropping Scraped Items

ساخت خزنده ها با استفاده از سرویس های داخلی در تراپی Building Crawlers Using Built-in Services in Scrapy

-

بررسی اجمالی ماژول Module Overview

-

ورود به سیستم Logging

-

اعلان های ایمیل Email Notifications

-

معرفی خزنده های گسترده Introducing Broad Crawls

-

پارامترهای خزنده گسترده و خزنده Broad Crawls and Crawling Parameters

-

اشکال زدایی با استفاده از Telnet Debugging Using Telnet

-

اتوتللینگ در خزنده های گسترده Autothrottling in Broad Crawlers

استقرار خزنده ها با استفاده از Cloud Cloud Deploying Crawlers Using Scrapy Cloud

-

بررسی اجمالی ماژول Module Overview

-

Scrap Developer Tools on the Cloud Scrapy Developer Tools on the Cloud

-

استقرار یک خزنده محلی ساخته شده در ابر اسكراپی Deploying a Locally Built Crawler to the Scrapy Cloud

-

گروه های کانتینر موجود در ابر اسكراپی Container Groups on the Scrapy Cloud

-

روی Scraping با Portia اشاره کرده و کلیک کنید Point and Click Scraping with Portia

-

اجرای عنکبوت ساخته شده با استفاده از Portia Running a Spider Built Using Portia

-

خلاصه و مطالعه بیشتر Summary and Further Study

جزییات دوره

1h 52m

38

Pluralsight (پلورال سایت)

(آخرین آپدیت)

36

4.5 از 5

دارد

دارد

دارد

https://donyad.com/d/215c

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات