آموزش ادغام داده ها در Microsoft Azure - آخرین آپدیت

Integrating Data in Microsoft Azure

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

خدمات یکپارچه سازی داده ها در Azure Data Integration Services on Azure

-

مقدمه Introduction

-

درباره خدمات Azure Data Integration اطلاعاتی کسب کنید Learning About Azure Data Integration Services

-

درک نیازهای یکپارچه سازی داده ها Understanding Data Integration Requirements

-

خلاصه Summary

انتقال داده های داخلی به Azure SQL Server Migrate On-premises Data to Azure SQL Server

-

مقدمه Introduction

-

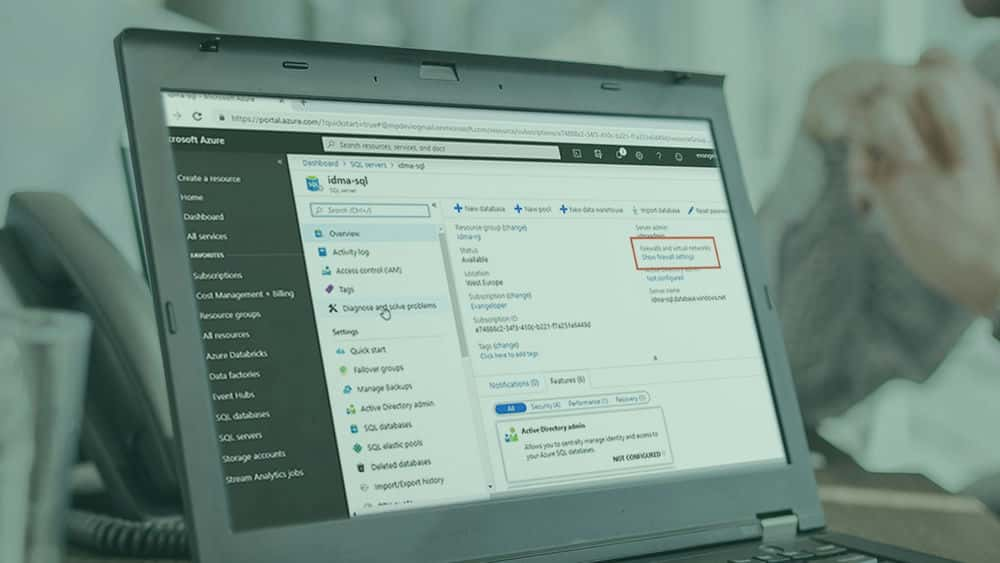

ایجاد Azure SQL Server و پایگاه داده Creating an Azure SQL Server and Database

-

با استفاده از کمک به Data Migration برای شناسایی مشکلات سازگاری و انتقال داده ها Using Data Migration Assistance to Detect Compatibility Issues and Migrate Data

-

معرفی Azure Data Factory Introducing Azure Data Factory

-

درک خطوط لوله ، فعالیت ها ، مجموعه داده ها و خدمات پیوند داده شده Understanding Pipelines, Activities, Datasets, and Linked Services

-

آشنایی با زمانهای ادغام Getting to Know Integration Runtimes

-

شناسایی دارایی های موجود در پایگاه داده و Azure SQL Identifying On-premises and Azure SQL Database Assets

-

آشنایی با رابط کاربری Azure Data Factory Getting Familiar with the Azure Data Factory UI

-

ایجاد اولین خط تولید کارخانه Azure Data Creating Your First Azure Data Factory Pipeline

-

ایجاد اولین فعالیت خط لوله داده Creating Your First Data Pipeline Activity

-

پرس و جو از یک جدول داخلی با استفاده از یک برنامه ادغام میزبان خودکار Querying an On-premises Table by Using a Self-hosted Integration Runtime

-

کپی کردن داده ها به طور فزاینده از پایگاه داده به پایگاه داده Azure SQL Copying Data Incrementally from On-premises to Azure SQL Database

-

اجرای روش ذخیره سازی پارامتر در خط لوله Azure Data Factory Executing a Parameterized Stored Procedure in an Azure Data Factory Pipeline

-

در حال اجرا و نظارت بر اجرای خط لوله Running and Monitoring a Pipeline Execution

-

خلاصه Summary

انتقال داده از Amazon S3 به Azure Blob Storage Migrate Data from Amazon S3 to Azure Blob Storage

-

مقدمه Introduction

-

شناسایی دارایی های ذخیره سازی Azure Blob Identifying Azure Blob Storage Assets

-

دریافت کلید دسترسی S3 آمازون Getting the Amazon's S3 Access Key

-

ایجاد خط لوله و فعالیت کپی Creating the Pipeline and Copy Activity

-

ایجاد مجموعه داده منبع و سرویس پیوندی Creating the Source Dataset and Linked Service

-

ایجاد Sink Dataset و Linked Service Creating the Sink Dataset and Linked Service

-

اعتبار سنجی ، اشکال زدایی ، انتشار ، راه اندازی و نظارت بر اجرای خطوط لوله Validating, Debugging, Publishing, Triggering, and Monitoring Pipeline Execution

-

خلاصه Summary

با استفاده از ابزار کپی داده Azure Data Fipelines داده ایجاد کنید Create Data Pipelines with Azure Data Factory Copy Data Tool

-

مقدمه Introduction

-

رفتن به & nbsp؛ دانستن ابزار کپی کردن داده ها Getting to Know Copy Data Tool

-

ایجاد خط لوله با ابزار کپی داده ADF Creating a Pipeline with ADF Copy Data Tool

-

مرور اجزای خط لوله ایجاد شده توسط ابزار کپی داده Reviewing Pipeline Components Created by Copy Data Tool

-

خلاصه Summary

خطوط لوله داده را با Azure Data Factory ایجاد کنید Create Data Pipelines with Azure Data Factory

-

مقدمه Introduction

-

ایجاد پارامترهای خط لوله و خط لوله Creating the Pipeline and Pipeline Parameters

-

افزودن فعالیت GetMetaData به خط لوله Adding a GetMetaData Activity to the Pipeline

-

افزودن یک فعالیت فیلتر به خط لوله Adding a Filter Activity to the Pipeline

-

ایجاد یک مجموعه داده قابل استفاده مجدد Creating a Reusable Dataset

-

افزودن یک فعالیت ForEach به خط لوله Adding a ForEach Activity to the Pipeline

-

معرفی Azure Databricks Introducing Azure Databricks

-

تبدیل داده با یک فعالیت نوت بوک Databricks Transforming Data with a Databricks Notebook Activity

-

ارسال ایمیل معاملاتی با برنامه های Azure Logic Sending Transactional Email with Azure LogicApps

-

حذف مرحله بندی پرونده ها با یک فعالیت حذف Deleting Staging Files with a Delete Activity

-

اجرا و نظارت بر اجرای خط لوله Executing and Monitoring Pipeline Execution

-

ایجاد ماشه ای که خط لوله را در یک برنامه اجرا می کند Creating a Trigger That Runs a Pipeline on a Schedule

-

معرفی جریان داده ها Introducing Data Flows

-

آموزش سایر روشهای ایجاد منابع Azure Data Factory Learning About Other Ways to Create Azure Data Factory Resources

-

یادگیری در مورد انواع دیگر ادغام هایی که ADF امکان پذیر می کند Learning About Other Type of Integrations That ADF Makes Possible

-

خلاصه Summary

با Azure EventHubs و Azure Stream Analytics خطوط داده در زمان واقعی ایجاد کنید Create Real-time Data Pipelines with Azure EventHubs and Azure Stream Analytics

-

مقدمه Introduction

-

ایجاد و پیکربندی EventHub ها Creating and Configuring EventHubs

-

معرفی ژنراتور سنسور آلودگی هوا Introducing the Air Pollution Sensor Generator

-

ایجاد یک کار تجزیه و تحلیل جریان Creating a Stream Analytics Job

-

ایجاد ورودی شغلی Stream Analytics Creating a Stream Analytics Job Input

-

ایجاد ورودی مرجع شغلی Stream Analytics Creating a Stream Analytics Job Reference Input

-

ایجاد یک خروجی شغلی Stream Analytics Creating a Stream Analytics Job Output

-

ایجاد یک جستجوی شغل Stream Analytics Creating a Stream Analytics Job Query

-

شروع کار Stream Analytics و مرور ابزارهای نظارت Starting a Stream Analytics Job and Reviewing Monitoring Tools

-

خلاصه Summary

نظارت بر زمان واقعی با Power BI Real-time Monitoring with Power BI

-

مقدمه Introduction

-

پیکربندی جریان تجزیه و تحلیل برای Power BI Configuring Stream Analytics for Power BI

-

مصرف رویدادهای خط لوله در زمان واقعی در Power BI Consuming Real-time Pipeline Events in Power BI

-

خلاصه Summary

https://donyad.com/d/2a8d

Marcelo Pastorino

Marcelo Pastorino

مارسلو با استفاده از C # ، .NET Framework و .NET Core ، Azure ، Xamarin ، JavaScript و فریمورک های مدرن جلویی در میان سایر فناوری ها ، 18 سال تجربه حرفه ای در حل مشکلات تجاری با معماری راه حل ها و توسعه نرم افزار برای وب ، ابر و تلفن همراه دارد. او یک توسعه دهنده پرشور و عملگرا است که اولین نرم افزار خود را در سن 16 سالگی به فروش رساند. مارسلو از اوایل دهه 90 شروع به کد نویسی برای سرگرمی در IBM 8086 XT قدیمی کرد. از آن زمان مارسلو با افتخار در ساخت نرم افزار با کیفیت در شرکت های مختلف در جهان در نقش های مختلف توسعه نرم افزار کار کرده است. او همچنین در حال کار بر روی یک پروژه جانبی ، یک جامعه باز برای توسعه دهندگان نرم افزار به نام SoftwareDeveloper.io است و با راهنمایی توسعه دهندگان مشتاق و مستقر ، به آنها کمک می کند مهارت های رمزگذاری خود را به سطح بالاتری برسانند ، اشتیاق جدیدی در آموزش پیدا کرده است.

نمایش نظرات