آموزش بررسی SDK پرتو Apache برای مدل سازی جریان داده ها برای پردازش - آخرین آپدیت

Exploring the Apache Beam SDK for Modeling Streaming Data for Processing

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیویی برای نمایش وجود ندارد.

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

درک خطوط لوله ، PCollections و PTransforms Understanding Pipelines, PCollections, and PTransforms

-

پیش نیازها و طرح کلی دوره Prerequisites and Course Outline

-

معرفی پرتو آپاچی Introducing Apache Beam

-

خطوط لوله و گزینه های خط لوله Pipelines and Pipeline Options

-

PCollections و PTransforms PCollections and PTransforms

-

ویژگی های PCLlections Characteristics of PCollections

-

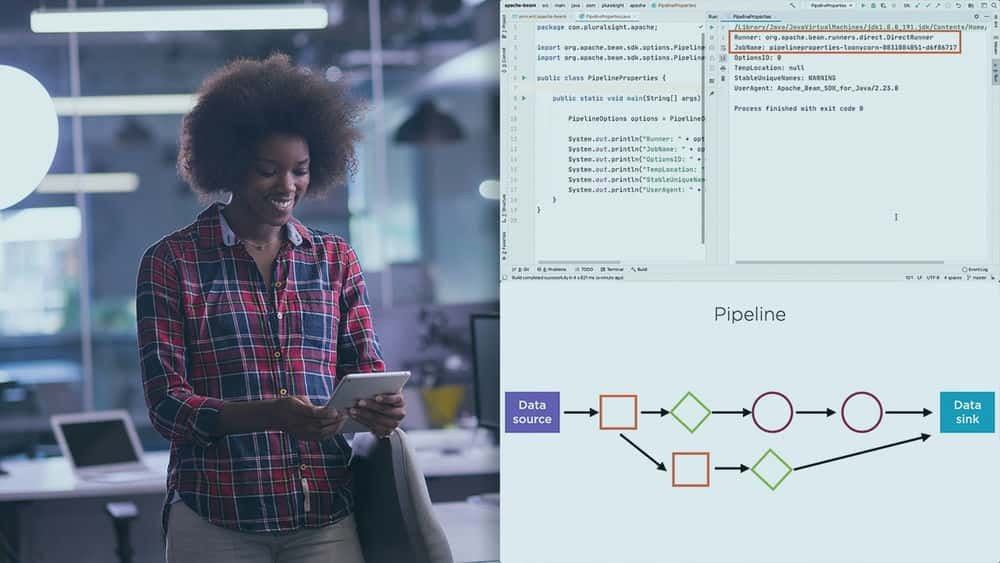

نسخه ی نمایشی: تنظیمات محیط و خصوصیات خط لوله Demo: Environment Setup and Pipeline Properties

-

رانندگان و دونده ها Drivers and Runners

اجرای خطوط لوله برای پردازش جریان داده ها Executing Pipelines to Process Streaming Data

-

نسخه ی نمایشی: ایجاد و اجرای خط لوله پرتو Demo: Creating and Executing a Beam Pipeline

-

نسخه ی نمایشی: مشخصات خط لوله با استفاده از عناصر نقشه و عناصر نقشه مسطح Demo: Pipeline Specification Using Map Elements and Flat Map Elements

-

نسخه ی نمایشی: منبع پرونده و پرونده ها غرق می شوند Demo: File Source and Files Sink

-

نسخه ی نمایشی: گزینه های خط لوله سفارشی Demo: Custom Pipeline Options

-

نسخه ی نمایشی: Flink Runner و Spark Runner Demo: Flink Runner and Spark Runner

-

نسخه ی نمایشی: مشخصات و استنباط طرح Demo: Schema Specification and Inference

-

نسخه ی نمایشی: خواندن داده ها با طرحواره از Files Demo: Reading Data with Schemas from Files

اعمال تحولات در جریان اطلاعات Applying Transformations to Streaming Data

-

تبدیل می شود Transforms

-

تبدیل پرتو هسته Core Beam Transforms

-

نسخه ی نمایشی: عملیات فیلتر کردن ParDo و DoFn Demo: ParDo and DoFn Filtering Operations

-

نسخه ی نمایشی: عملیات استخراج و قالب بندی ParDo و DoFn Demo: ParDo and DoFn Extracting and Formatting Operations

-

نسخه ی نمایشی: عملیات محاسباتی ParDo و DoFn Demo: ParDo and DoFn Computation Operations

-

نسخه ی نمایشی: GroupByKey و Aggregations Demo: GroupByKey and Aggregations

-

نسخه ی نمایشی: CoGroupByKey برای پیوستن به مجموعه داده ها Demo: CoGroupByKey for Joining Datasets

-

نسخه ی نمایشی: ترکیب کنید Demo: Combine

-

نسخه ی نمایشی: Flatten Demo: Flatten

-

نسخه ی نمایشی: پارتیشن بندی Demo: Partition

-

نسخه ی نمایشی: تحولات مرکب Demo: Composite Transforms

-

الزامات کد تبدیل کاربر User Transform Code Requirements

کار با Windowing و پیوستن به عملیات Working with Windowing and Join Operations

-

تحولات بدون دولت و دولت Stateless and Stateful Transformations

-

انواع ویندوز Types of Windows

-

زمان رویداد ، زمان بلع و زمان پردازش Event Time, Ingestion Time, and Processing Time

-

علامت های آبی و داده های بعدی Watermarks and Late Data

-

نسخه ی نمایشی: ویندوز ثابت Demo: Fixed Windows

-

نسخه ی نمایشی: ویندوزهای کشویی Demo: Sliding Windows

-

نسخه ی نمایشی: ویندوز جلسه Demo: Session Windows

-

نسخه ی نمایشی: ویندوزهای جهانی Demo: Global Windows

-

نسخه ی نمایشی: ورودی های جانبی Demo: Side Inputs

-

نسخه ی نمایشی: Inner Join Demo: Inner Join

-

نسخه ی نمایشی: Outer Joins Demo: Outer Joins

-

نسخه ی نمایشی: با استفاده از ورودی های جانبی بپیوندید Demo: Join Using Side Inputs

-

نسخه ی نمایشی: انجام پیوستن ها با استفاده از CoGroupByKey - 1 Demo: Performing Joins Using CoGroupByKey - 1

-

نسخه ی نمایشی: اجرا با استفاده از CoGroupByKey - 2 Demo: Performing Joins Using CoGroupByKey - 2

-

Apache Flink و Apache Spark 2: سازگاری با Apache Beam Apache Flink and Apache Spark 2: Compatibility with Apache Beam

SQL Query را روی Streaming Data انجام دهید Perform SQL Queries on Streaming Data

-

معیارها در Beam Metrics in Beam

-

نسخه ی نمایشی: معیارهای شمارنده Demo: Counter Metrics

-

نسخه ی نمایشی: معیارهای توزیع Demo: Distribution Metrics

-

نسخه ی نمایشی: معیارهای سنج Demo: Gauge Metrics

-

نسخه ی نمایشی: پروجکشن و تجمیع انتخاب با استفاده از SQL query Demo: Selection Projection and Aggregation Using SQL Queries

-

نسخه ی نمایشی: طرحواره هایی با ساختارهای تو در تو Demo: Schemas with Nested Structures

-

نسخه ی نمایشی: با استفاده از SQL Query می پیوندد Demo: Joins Using SQL Queries

-

خلاصه و مطالعه بیشتر Summary and Further Study

https://donyad.com/d/fefc

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات