آموزش معماری راه حل های Big Data با استفاده از Google Dataproc - آخرین آپدیت

Architecting Big Data Solutions Using Google Dataproc

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیویی برای نمایش وجود ندارد.

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

معرفی Google Dataproc برای Big Data on the Cloud Introducing Google Dataproc for Big Data on the Cloud

-

بررسی اجمالی ماژول Module Overview

-

پیش نیازها ، طرح کلی دوره و سناریوهای فروش Spikey Prerequisites, Course Outline, and Spikey Sales Scenarios

-

پردازش توزیع شده Distributed Processing

-

ذخیره سازی در Hadoop سنتی Storage in Traditional Hadoop

-

در Hadoop سنتی محاسبه کنید Compute in Traditional Hadoop

-

جدا کردن فضای ذخیره سازی و محاسبه با Dataproc Separating Storage and Compute with Dataproc

-

هادوپ در مقابل داتاپروک Hadoop vs. Dataproc

-

با استفاده از Cloud Shell ، فعال کردن Dataproc API Using the Cloud Shell, Enabling the Dataproc API

-

ویژگی های Dataproc Dataproc Features

-

مهاجرت به دیتاپروک Migrating to Dataproc

-

Dataproc قیمت گذاری Dataproc Pricing

اجرای Hadoop Map شغل را در Google Dataproc کاهش دهید Running Hadoop MapReduce Jobs on Google Dataproc

-

بررسی اجمالی ماژول Module Overview

-

ایجاد یک خوشه Dataproc با استفاده از کنسول وب Creating a Dataproc Cluster Using the Web Console

-

با استفاده از SSH برای اتصال به Master Node Using SSH to Connect to the Master Node

-

ایجاد یک قانون فایروال برای فعال کردن دسترسی به Dataproc Creating a Firewall Rule to Enable Access to Dataproc

-

دسترسی به مدیر منابع و UI نام گره Accessing the Resource Manager and Name Node UI

-

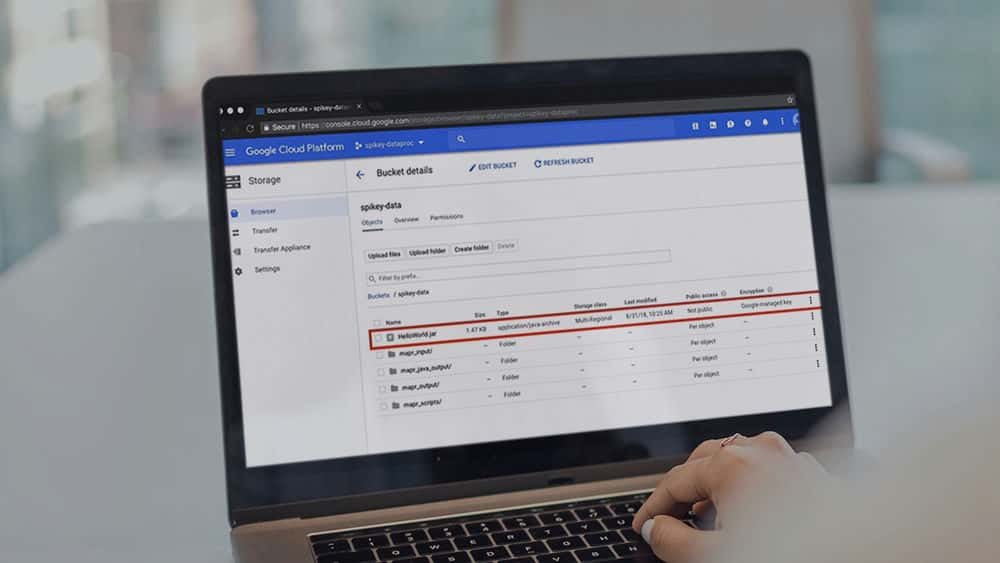

داده و کد MapReduce را در Cloud Storage بارگذاری کنید Upload Data and MapReduce Code to Cloud Storage

-

اجرای MapReduce در Dataproc Running MapReduce on Dataproc

-

اجرای MapReduce با استفاده از ابزار خط فرمان gcloud Running MapReduce Using the gcloud Command Line Utility

-

ایجاد یک خوشه با نمونه های ترجیحی با استفاده از gcloud Creating a Cluster with Preemptible Instances Using gcloud

-

نظارت بر خوشه ها با استفاده از Stackdriver Monitoring Clusters Using Stackdriver

-

Stackdriver Monitoring Groups و خطوط هشدار Stackdriver Monitoring Groups and Alerting Policies

-

پیکربندی اقدامات اولیه برای Dataproc Configuring Initialization Actions for Dataproc

کار با Apache Spark در Google Dataproc Working with Apache Spark on Google Dataproc

-

بررسی اجمالی ماژول Module Overview

-

جرقه برای پردازش توزیع شده Spark for Distributed Processing

-

اجرای Spark Scala Job با استفاده از کنسول وب Running a Spark Scala Job Using the Web Console

-

اجرای برنامه Spark با استفاده از gcloud Executing a Spark Application Using gcloud

-

ایجاد یک جدول BigQuery Creating a BigQuery Table

-

برنامه Pyspark با استفاده از BiqQuery و اتصالات ذخیره سازی ابر Pyspark Application Using BiqQuery and Cloud Storage Connectors

-

اجرای یک برنامه Spark برای گرفتن نتیجه در BigQuery Executing a Spark Application to Get Results in BigQuery

-

نظارت بر مشاغل جرقه در Dataproc Monitoring Spark Jobs on Dataproc

کار با Pig and Hive در Google Dataproc Working with Pig and Hive on Google Dataproc

-

بررسی اجمالی ماژول Module Overview

-

خوک برای استخراج بار تبدیل Pig for Extract Transform Load

-

اجرای اسکریپت های خوک در Dataproc Running Pig Scripts on Dataproc

-

ذخیره خروجی خوک در فضای ذخیره سازی ابری Storing Pig Output to Cloud Storage

-

جستجوی داده های بزرگ Hive to Query Big Data

-

اجرای نمایش داده های کندو در Dataproc Executing Hive Queries on Dataproc

-

خلاصه و مطالعه بیشتر Summary and Further Study

جزییات دوره

2h 17m

39

Pluralsight (پلورال سایت)

(آخرین آپدیت)

14

4.9 از 5

دارد

دارد

دارد

https://donyad.com/d/8b74

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات