آموزش بهینه سازی اسپارک آپاچی در دیتابریکس - آخرین آپدیت

Optimizing Apache Spark on Databricks

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیویی برای نمایش وجود ندارد.

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

کاوش و کاهش مشکلات بلع داده ها Exploring and Mitigating Data Ingestion Problems

-

بررسی نسخه Version Check

-

پیش نیازها و رئوس مطالب دوره Prerequisites and Course Outline

-

دریاچه دلتا Delta Lake

-

جذب داده ها: تعریف، چالش ها و بهترین شیوه ها Data Ingestion: Definition, Challenges, and Best Practices

-

لودر خودکار برای بلع داده ها Auto Loader for Data Ingestion

-

نسخه ی نمایشی: ایجاد یک منبع ذخیره سازی ابری خارجی برای جذب فایل ها Demo: Creating an External Cloud Storage Source for Ingestion of Files

-

نسخه ی نمایشی: مصرف جریان داده ها در دریاچه دلتا Demo: Ingesting Streaming Data into Delta Lake

-

نسخه ی نمایشی: ردیابی فایل های پردازش شده با استفاده از بارگذار خودکار Demo: Tracking Processed Files using Auto Loader

-

نسخه ی نمایشی: مصرف داده های دسته ای در دریاچه دلتا Demo: Ingesting Batch Data into Delta Lake

-

نسخه ی نمایشی: مصرف داده ها در دریاچه دلتا با استفاده از SQL Demo: Ingesting Data into Delta Lake Using SQL

-

Databricks Data Ingestion Network Databricks Data Ingestion Network

تشخیص و کاهش مشکلات عملکرد Diagnosing and Mitigating Performance Problems

-

مشکلات عملکرد در Spark Performance Issues in Spark

-

تنگناهای عملکرد در Spark: Serialization و Skew Performance Bottlenecks in Spark: Serialization and Skew

-

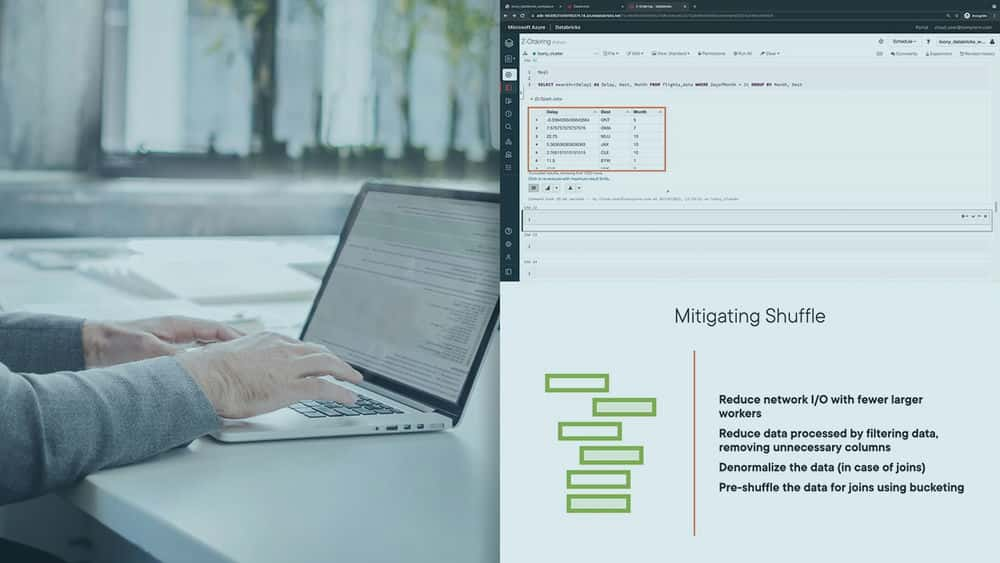

تنگناهای عملکرد در Spark: Spill، Shuffle و Memory Performance Bottlenecks in Spark: Spill, Shuffle, and Memory

-

پارتیشن های حافظه و پارتیشن های دیسک Memory Partitions and Disk Partitions

-

نسخه ی نمایشی: پارتیشن بندی دیسک Demo: Disk Partitioning

-

پرش داده ها و خوشه بندی Z-order Data Skipping and Z-order Clustering

-

نسخه ی نمایشی: Z-ordering در یک میز دلتا کوچک Demo: Z-ordering on a Small Delta Table

-

نسخه ی نمایشی: Z-ordering در یک میز دلتا بزرگ Demo: Z-ordering on a Large Delta Table

-

Bucketing برای بهینه سازی اتصالات Bucketing to Optimize Joins

-

نسخه ی نمایشی: جداول سطل دار و بدون سطل Demo: Bucketed and Unbucketed Tables

-

نسخه ی نمایشی: پیوستن به جداول سطلی و بدون سطل Demo: Joining Bucketed and Unbucketed Tables

بهینه سازی جرقه برای عملکرد Optimizing Spark for Performance

-

FIFO و Fair Schedulers FIFO and Fair Schedulers

-

نسخه ی نمایشی: برنامه ریزی پیش فرض استخر FIFO Demo: Default Pool FIFO Scheduling

-

نسخه ی نمایشی: پیکربندی استخرهای مختلف برای به اشتراک گذاری منابع Demo: Configuring Different Pools to Share Resources

-

دلتا کش Delta Cache

-

نسخه ی نمایشی: پیکربندی کش دلتا در یک کلاستر Demo: Configuring the Delta Cache on a Cluster

-

نسخه ی نمایشی: اجرای پرس و جو بر روی داده های ذخیره شده Demo: Running Queries on Cached Data

-

ویژگی های جدید Apache Spark 3.0 New Features in Apache Spark 3.0

-

خلاصه و مطالعه بیشتر Summary and Further Study

https://donyad.com/d/9c80

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات