آموزش پردازش داده های جریانی با Apache Spark در Databricks - آخرین آپدیت

Processing Streaming Data with Apache Spark on Databricks

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیوها:

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

مروری بر معماری استریمینگ در آپاچی اسپارک Overview of the Streaming Architecture in Apache Spark

-

بررسی نسخه Version Check

-

پیش نیازها و رئوس مطالب دوره Prerequisites and Course Outline

-

پردازش دسته ای در مقابل پردازش جریانی Batch Processing vs. Stream Processing

-

میکرو دسته ای و پردازش مداوم Micro-batch and Continuous Processing

-

پردازش جریان در آپاچی اسپارک Stream Processing in Apache Spark

-

کاربردهای مداوم در Spark Continuous Applications in Spark

-

نسخه ی نمایشی: خواندن داده های دسته ای و جریانی Demo: Reading Batch and Streaming Data

-

نسخه ی نمایشی: اجرای یک جستجوی جریانی ساده Demo: Running a Simple Streaming Query

-

نسخه ی نمایشی: پردازش و تجسم جریان ها Demo: Processing and Visualizing Streams

-

محرک ها Triggers

-

نسخه ی نمایشی: پیکربندی تریگرها Demo: Configuring Triggers

-

خلاصه ماژول Module Summary

اعمال تبدیل در داده های جریانی Applying Transformations on Streaming Data

-

منابع و سینک های جریان Streaming Sources and Sinks

-

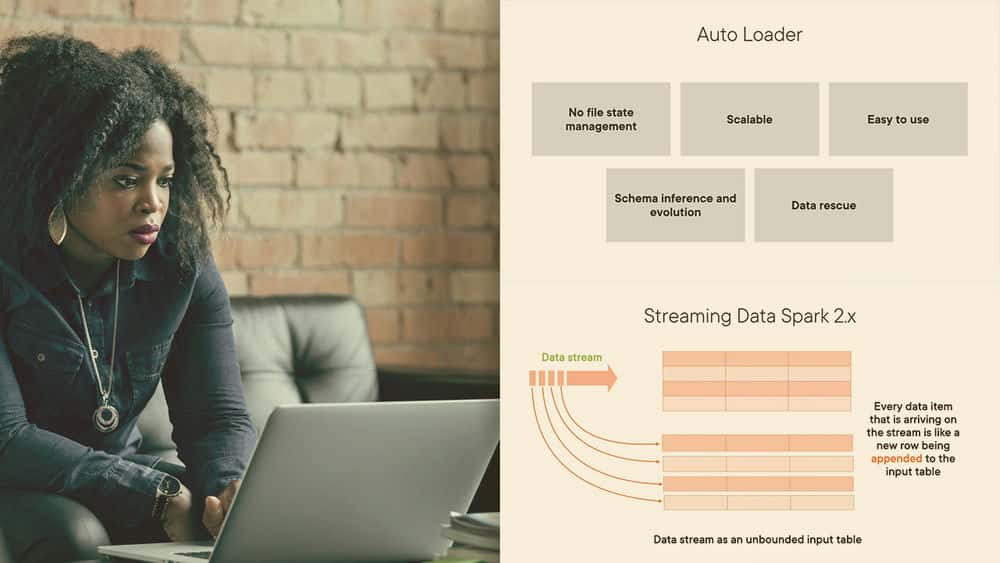

لودر خودکار Auto Loader

-

نسخه ی نمایشی: بارگذار خودکار و داده های نجات یافته Demo: Auto Loader and Rescued Data

-

نسخه ی نمایشی؛ نوشتن جریان در فایل سینک Demo; Writing Streams to File Sinks

-

نسخه ی نمایشی: انجام تبدیل در جریان ها Demo: Performing Transformations on Streams

-

نسخه ی نمایشی: پردازش جریانی Demo: Stream Processing

-

حالت های خروجی Output Modes

-

نسخه ی نمایشی: حالت افزودن Demo: Append Mode

-

نسخه ی نمایشی: حالت کامل Demo: Complete Mode

-

نسخه ی نمایشی: حالت به روز رسانی Demo: Update Mode

اجرای پرس و جوهای SQL در جریان داده ها Executing SQL Queries on Streaming Data

-

نسخه ی نمایشی: اجرای پرس و جوهای SQL برای پردازش جریان ها Demo: Executing SQL Queries to Process Streams

-

نسخه ی نمایشی: ایجاد یک کاربر AWS و سطل S3 Demo: Creating an AWS User and S3 Bucket

-

نسخه ی نمایشی: نصب یک سطل S3 در DBFS Demo: Mounting an S3 Bucket to DBFS

-

نسخه ی نمایشی: لودر خودکار برای خواندن از منبع سطل S3 Demo: Auto Loader to Read from an S3 Bucket Source

-

نسخه ی نمایشی: استفاده از UDF در جریان داده ها Demo: Applying UDFs on Streaming Data

-

ایست بازرسی Checkpointing

-

نسخه ی نمایشی: ایست بازرسی Demo: Checkpointing

-

نسخه ی نمایشی: اجرای یک کار جریانی در یک کلاستر Demo: Running a Streaming Job on a Cluster

-

نسخه ی نمایشی: مشاهده نتایج کار Demo: Viewing Job Results

-

خلاصه و مطالعه بیشتر Summary and Further Study

https://donyad.com/d/e169ba

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات