آموزش بررسی API جریان ساختاری Apache Spark برای پردازش داده های جریان - آخرین آپدیت

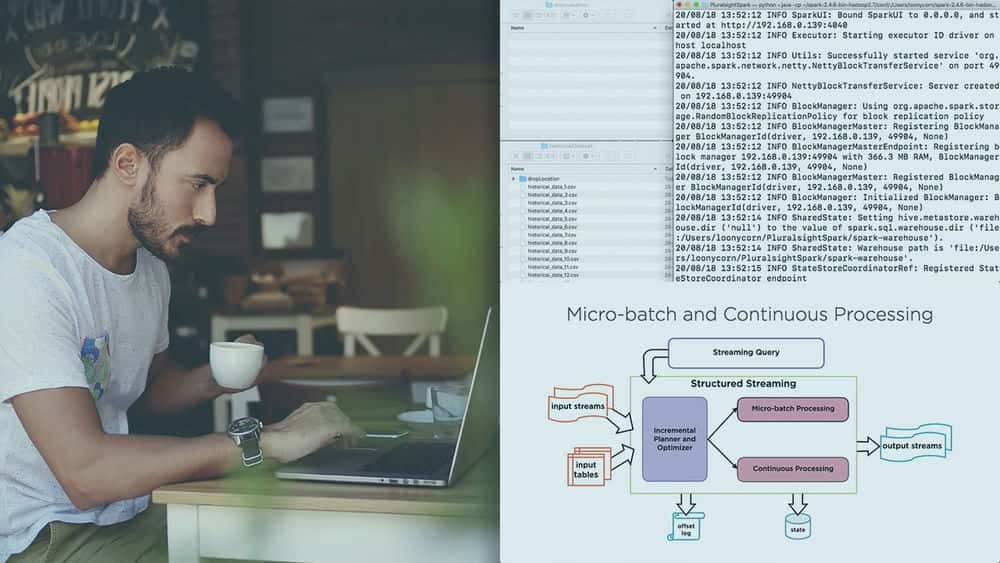

Exploring the Apache Spark Structured Streaming API for Processing Streaming Data

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیویی برای نمایش وجود ندارد.

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

کاوش در منابع و غرق ها Exploring Sources and Sinks

-

پیش نیازها و طرح کلی دوره Prerequisites and Course Outline

-

پخش جریانی داده ها در Spark 2.x Streaming DataFrames in Spark 2.x

-

منابع و غرق ها Sources and Sinks

-

نسخه ی نمایشی: تنظیم محیط Demo: Environment Setup

-

نسخه ی نمایشی: سینک ظرفشویی Demo: Console Sink

-

نسخه ی نمایشی: File Sink با پرونده های CSV و JSON Demo: File Sink with CSV and JSON Files

-

نسخه ی نمایشی: فروغ غرق Demo: Foreach Sink

-

نسخه ی نمایشی: غرق دسته ای Foreach Demo: Foreach Batch Sink

پردازش فریم های داده جریان Processing Streaming Data Frames

-

راه اندازها Triggers

-

حالت های خروجی Output Modes

-

نسخه ی نمایشی: گزینه ها و پیش بینی ها Demo: Selections and Projections

-

نسخه ی نمایشی: فیلتر کردن و س Sالات SQL Demo: Filtering and SQL Queries

-

نسخه ی نمایشی: تجمیع با استفاده از DataFrames و SQL query Demo: Aggregation Using DataFrames and SQL Queries

-

نسخه ی نمایشی: پیش فرض و ثابت میکرو دسته ای و راه اندازهای یکبار مصرف Demo: Default and Fixed Interval Micro-batch and One-time Triggers

-

عملیات پشتیبانی نشده در DataFrames Unsupported Operations on DataFrames

انجام عملیات پنجره سازی در جریان ها Performing Windowing Operations on Streams

-

تحولات بدون دولت و دولت Stateless and Stateful Transformations

-

Tumbling ، Sliding و Global Windows Tumbling, Sliding, and Global Windows

-

زمان رویداد و زمان پردازش Event Time and Processing Time

-

نسخه ی نمایشی: پنجره جهانی پیش فرض Demo: Default Global Window

-

نسخه ی نمایشی: Tumbling Window Demo: Tumbling Window

-

نسخه ی نمایشی: پنجره کشویی Demo: Sliding Window

-

علامت های آبی و داده های بعدی Watermarks and Late Data

-

نسخه ی نمایشی: علامت های آبی Demo: Watermarks

-

نسخه ی نمایشی: ایجاد UDF برای استفاده با Data Frames و در SQL Query Demo: Creating UDFs to Use with Data Frames and in SQL Queries

-

نسخه ی نمایشی: UDF ها و عملیات پنجره سازی Demo: UDFs and Windowing Operations

کار با Streaming Joins Working with Streaming Joins

-

اجرای Joins در جریان ها Performing Joins on Streams

-

نسخه ی نمایشی: کاوش مجموعه های دسته ای و جریان Demo: Exploring Batch and Streaming Datasets

-

نسخه ی نمایشی: پیوستن به داده های دسته ای و جریانی Demo: Joining Batch and Streaming Data

-

نسخه ی نمایشی: با استفاده از چند ستون و عبارت به هم می پیوندد Demo: Joins Using Multiple Columns and Expressions

-

نسخه ی نمایشی: آبشار با چندین جریان می پیوندد Demo: Cascading Joins with Multiple Streams

-

نسخه ی نمایشی: راست بیرونی و چپ بیرونی می پیوندد Demo: Right Outer and Left Outer Joins

-

نسخه ی نمایشی: پخش جریانی جریان می پیوندد Demo: Streaming-streaming Joins

مدیریت و نظارت بر س Quالات پخش جریانی Managing and Monitoring Streaming Queries

-

مدیریت سeriesالات Managing Queries

-

نسخه ی نمایشی: معیارهای سeryال تعاملی Demo: Interactive Query Metrics

-

نسخه ی نمایشی: کاوش رابط کاربر Spark Web Demo: Exploring the Spark Web UI

-

نسخه ی نمایشی: سرور Spark History Demo: Spark History Server

-

Apache Spark پشتیبانی برای API های پرتو Apache Apache Spark Support for Apache Beam APIs

-

خلاصه و مطالعه بیشتر Summary and Further Study

https://donyad.com/d/4f67

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات