آموزش پردازش داده های جریان با استفاده از جریان ساختار یافته Apache Spark - آخرین آپدیت

دانلود Processing Streaming Data Using Apache Spark Structured Streaming

نکته:

ممکن هست محتوای این صفحه بروز نباشد ولی دانلود دوره آخرین آپدیت می باشد.

نمونه ویدیوها:

سرفصل ها و درس ها

بررسی اجمالی دوره Course Overview

-

بررسی اجمالی دوره Course Overview

شروع کار با خوشه مستقل Spark Getting Started with the Spark Standalone Cluster

-

بررسی نسخه Version Check

-

پیش نیازها و طرح کلی دوره Prerequisites and Course Outline

-

پیش نیازها و رئوس مطالب دوره Prerequisites and Course Outline

-

رانندگان ، کارگران ، مجریان و وظایف Drivers, Workers, Executors, and Tasks

-

رانندگان ، کارگران ، مجریان و وظایف Drivers, Workers, Executors, and Tasks

-

معرفی Spark Standalone Introducing Spark Standalone

-

طرح های در دسترس بودن بالا High Availability Schemes

-

معرفی Stark Standalone Introducing Spark Standalone

-

نسخه ی نمایشی: Spark را بر روی دستگاه محلی خود نصب و تنظیم کنید Demo: Install and Set up Spark on Your Local Machine

-

طرح های در دسترس بودن بالا High Availability Schemes

-

نسخه ی نمایشی: Spark را روی دستگاه محلی خود نصب و تنظیم کنید Demo: Install and Set up Spark on Your Local Machine

-

نسخه ی نمایشی: فرآیندهای اصلی و کارگری را شروع کنید Demo: Start Master and Worker Processes

-

نسخه ی نمایشی: فرآیندهای استاد و کارگران را شروع کنید Demo: Start Master and Worker Processes

-

نسخه ی نمایشی: پیکربندی فایل ها برای گره های کارگر Demo: Config Files for Worker Nodes

-

نسخه ی نمایشی: پیکربندی پردازش با استفاده از آرگومان های خط فرمان Demo: Configuring Processing Using Command Line Arguments

-

نسخه ی نمایشی: پرونده ها را برای گره های کارگر پیکربندی کنید Demo: Config Files for Worker Nodes

-

نسخه ی نمایشی: رابط کاربر Spark Web برای نظارت بر برنامه ها Demo: The Spark Web UI for Monitoring Applications

-

نسخه ی نمایشی: پیکربندی پردازش با استفاده از آرگومان های خط فرمان Demo: Configuring Processing Using Command Line Arguments

-

نسخه ی نمایشی: پیکربندی در دسترس بودن بالا با Zookeeper Demo: High Availability Configuration with Zookeeper

-

نسخه ی نمایشی: UI Web Spark برای نظارت بر برنامه ها Demo: The Spark Web UI for Monitoring Applications

-

نسخه ی نمایشی: پیکربندی Spark Environment با استفاده از Config Files Demo: Configuring the Spark Environment Using Config Files

-

نسخه ی نمایشی: پیکربندی در دسترس بودن بالا با Zookeeper Demo: High Availability Configuration with Zookeeper

-

نسخه ی نمایشی: پیکربندی محیط جرقه با استفاده از پرونده های پیکربندی Demo: Configuring the Spark Environment Using Config Files

-

امنیت برای خوشه های جرقه ای Security for Spark Clusters

-

امنیت برای خوشه های جرقه Security for Spark Clusters

-

فشار پشت Backpressure

-

فشار Backpressure

ادغام Spark با Apache Kafka Integrating Spark with Apache Kafka

-

معماری اول جریان Stream-first Architecture

-

معرفی آپاچی کافکا Introducing Apache Kafka

-

نسخه ی نمایشی: نصب و تنظیم آپاچی کافکا Demo: Installing and Setting up Apache Kafka

-

نسخه ی نمایشی: ناشران ، مصرف کنندگان و مباحث Demo: Publishers, Consumers, and Topics

-

نسخه ی نمایشی: ایجاد یک حساب توسعه دهنده در توییتر Demo: Creating a Developer Account on Twitter

-

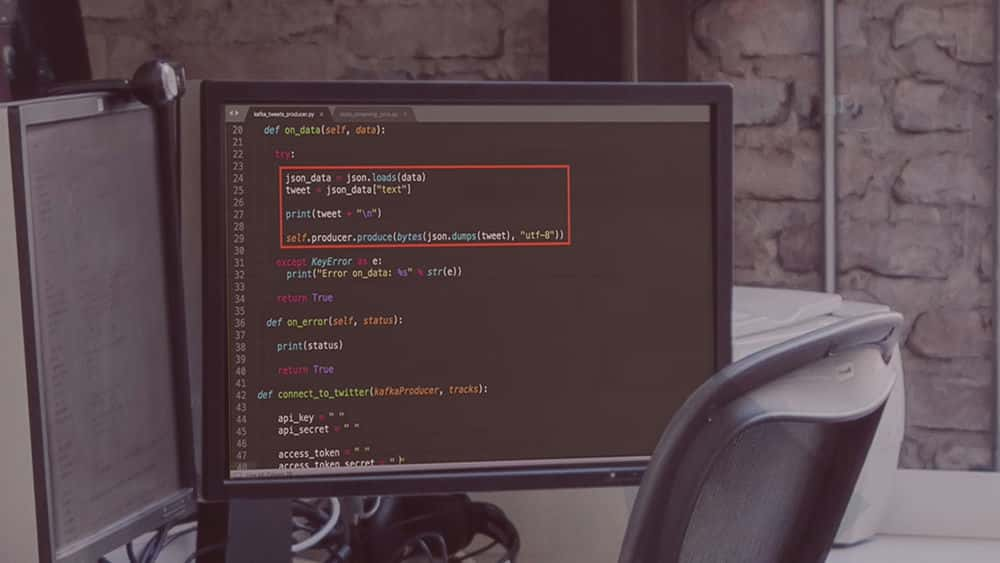

نسخه ی نمایشی: اتصال به توییتر با استفاده از Tweepy Demo: Connecting to Twitter Using Tweepy

-

نسخه ی نمایشی: استخراج و شمارش هشتگ از یک جریان توییتر Demo: Extracting and Counting Hashtags from a Twitter Stream

-

نسخه ی نمایشی: خواندن پیام از ناشر متعدد Demo: Reading Messages from Multiple Publishers

-

نسخه ی نمایشی: خواندن از چندین موضوع Demo: Reading from Multiple Topics

-

نسخه ی نمایشی: خواندن از چندین موضوع با استفاده از یک عبارت منظم Demo: Reading from Multiple Topics Using a Regular Expression

-

نسخه ی نمایشی: انجام تجزیه و تحلیل احساسات در توییت های ورودی Demo: Performing Sentiment Analysis on Input Tweets

-

نسخه ی نمایشی: اختصاص وضعیت احساسات به توییت Demo: Assigning Sentiment Status to Tweets

-

نسخه ی نمایشی: نوشتن به یک سینک کافکا و سینک پیشانی Demo: Writing to a Kafka Sink and Foreach Sink

انجام عملیات پنجره سازی در جریان ها Performing Windowing Operations on Streams

-

نمای کلی از پنجره و زمان Brief Overview of Windowing and Time

-

نسخه ی نمایشی: استخراج زمان رویداد و ارتباط زمان پردازش Demo: Extracting Event Time and Associating Processing Time

-

نسخه ی نمایشی: محاسبه تجمع در یک پنجره جهانی Demo: Computing Aggregations within a Global Window

-

نسخه ی نمایشی: استفاده از ویندوزهای فروکش و پنجره های کشویی Demo: Applying Tumbling Windows and Sliding Windows

انجام عملیات عضویت در جریان ها Performing Join Operations on Streams

-

جریان می یابد Streaming Joins

-

نسخه ی نمایشی: اجرای جریان استاتیک Demo: Performing Static Streaming Joins

-

نسخه ی نمایشی: نوشتن نتایج به یک موضوع کافکا Demo: Writing Join Results to a Kafka Topic

-

نسخه ی نمایشی: نوشتن نتایج به پرونده پارکت Demo: Writing Join Results to a Parquet File

-

نسخه ی نمایشی: آزمایش واحد UDF Demo: Unit Testing UDFs

-

نسخه ی نمایشی: آزمایش دستی پایان به پایان یک برنامه جرقه Demo: Manual End-to-end Testing of a Spark Application

-

خلاصه و مطالعه بیشتر Summary and Further Study

جزییات دوره

2h 35m

52

Pluralsight (پلورال سایت)

(آخرین آپدیت)

21

4.9 از 5

دارد

دارد

دارد

https://donyad.com/d/3076

Janani Ravi

Janani Ravi

معمار و مهندس داده خبره Google Cloud

Janani Ravi یک معمار و مهندس داده خبره Google cloud است.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

جنانی مدرک کارشناسی ارشد خود را در رشته مهندسی برق از دانشگاه استنفورد دریافت کرد و برای مایکروسافت، گوگل و فلیپ کارت کار کرده است. او یکی از بنیانگذاران Loonycorn است، یک استودیوی محتوا که بر ارائه محتوای با کیفیت بالا برای توسعه مهارت های فنی متمرکز است، جایی که او عشق خود را به فناوری با اشتیاق خود به تدریس ترکیب می کند.

نمایش نظرات