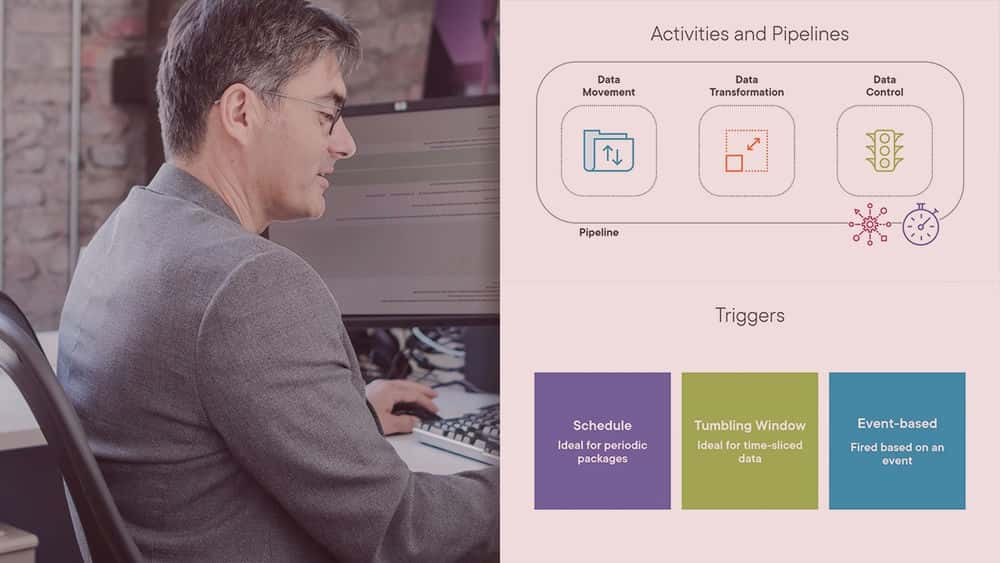

آموزش خطوط لوله داده را با کارخانه داده لاجورد و تجزیه و تحلیل سیناپس بهینه کنید

Optimize Data Pipelines with Azure Data Factory and Synapse Analytics

مهندسی داده در حال حاضر موضوع داغ فناوری اطلاعات است، زیرا سرعت، حجم و تنوع دادهها امروزه به مهارتهایی فراتر از ETL سنتی نیاز دارد. این دوره به شما یاد می دهد که چگونه خطوط لوله داده را در Azure به عنوان آمادگی برای آزمون DP-203 مدیریت کنید.

آموزش پردازش داده های بدون سرور با جریان داده: توسعه خطوط لوله

Serverless Data Processing with Dataflow: Develop Pipelines

در این قسمت دوم از سری دوره های Dataflow، ما قصد داریم در توسعه خطوط لوله با استفاده از Beam SDK بیشتر غواصی کنیم. ما با بررسی مفاهیم پرتو آپاچی شروع می کنیم. در مرحله بعد، ما در مورد پردازش داده های جریان با استفاده از ویندوز،...

آموزش ساخت خطوط لوله ETL از طریق پخش جریانی داده با کافکا و ksqlDB

Building ETL Pipelines from Streaming Data with Kafka and ksqlDB

کافکا می تواند کارهایی فراتر از ذخیره اطلاعات جریانی داشته باشد. این دوره به شما آموزش می دهد تا داده ها را در کافکا با ksqlDB و جریان های کافکا جمع آوری و تجزیه و تحلیل کنید.

آموزش ساخت خطوط لوله داده ای در GCP

Building Batch Data Pipelines on GCP

خطوط لوله داده به طور معمول در یکی از پارادایم های Extra-Load ، Extract-Load-Transform یا Extract-Transform-Load قرار می گیرند. این دوره توصیف می کند که از چه الگویی باید استفاده شود و چه زمانی برای داده های دسته ای.

آموزش تولید خطوط لوله داده با جریان هوا Apache

Productionalizing Data Pipelines with Apache Airflow

این دوره به شما می آموزد که چطور در Apache Airflow با سهولت در خطوط تولید داده با درجه تولید تسلط پیدا کنید.

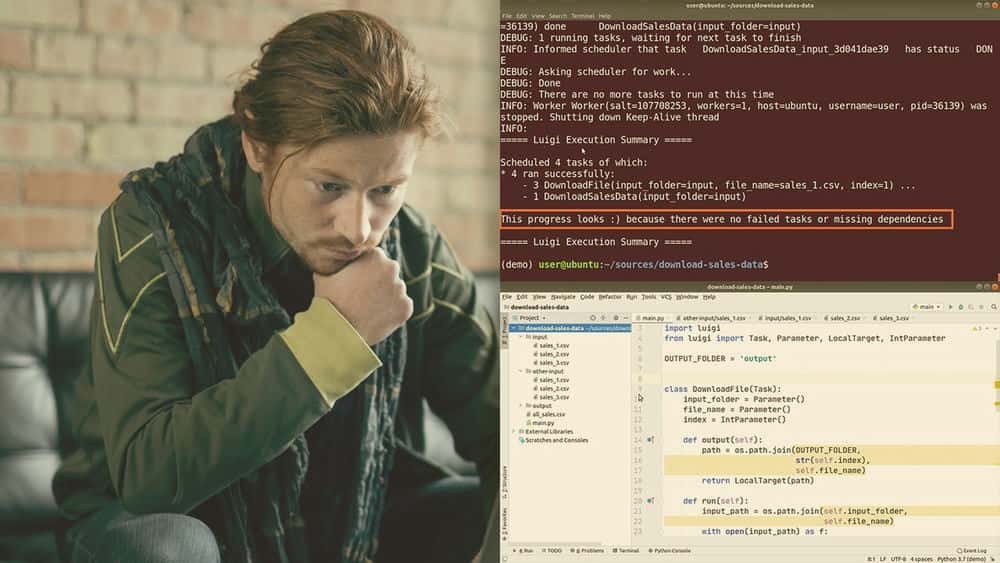

آموزش ساخت خطوط لوله داده با لوئیجی و پایتون

Building Data Pipelines with Luigi and Python

سایر توسعه دهندگان خطوط لوله داده را با قرار دادن مجموعه ای از اسکریپت های هکی پیاده سازی می کنند که با گذشت زمان به مسئولیت ها و کابوس های تعمیر و نگهداری تبدیل می شوند. این دوره را برای اجرای خطوط انتقال داده هوشمند و هوشمند با لوئیجی در پایتون بگذرانید.

آموزش ساخت خطوط لوله جریان داده در Microsoft Azure

Building Streaming Data Pipelines in Microsoft Azure

آیا شما نیاز به پردازش جریان داده های زنده از حسگرها ، برنامه های سفارشی ، دستگاه های اینترنت اشیا و گزارش ها دارید؟ آیا لازم است بلافاصله به ناهنجاری ها و الگوهای موجود در جریان داده های زنده پاسخ دهید؟ آیا با T-SQL آشنا هستید؟ در این صورت ، Azure Stream Analytics برای شما مناسب است.

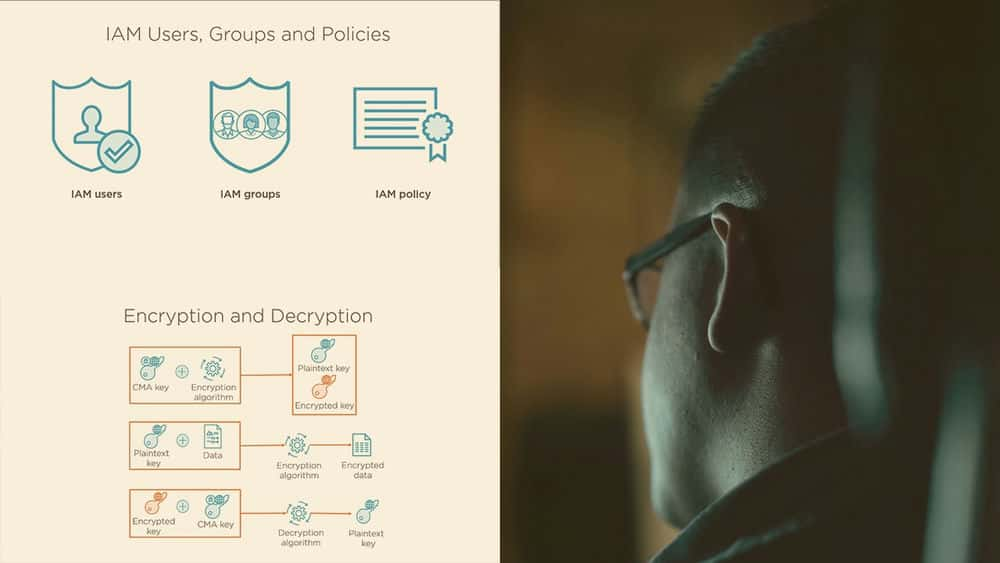

آموزش ایمن سازی خطوط لوله تجزیه و تحلیل داده ها در AWS

Securing Data Analytics Pipelines on AWS

همزمان با شروع آمادگی برای آزمون تخصصی تجزیه و تحلیل داده های گواهینامه AWS ، باید به جنبه امنیتی این گواهینامه بسیار توجه کنید. این دوره به شما آموزش می دهد که چگونه کنترل دسترسی و رمزگذاری داده های خود را تنظیم کنید ...

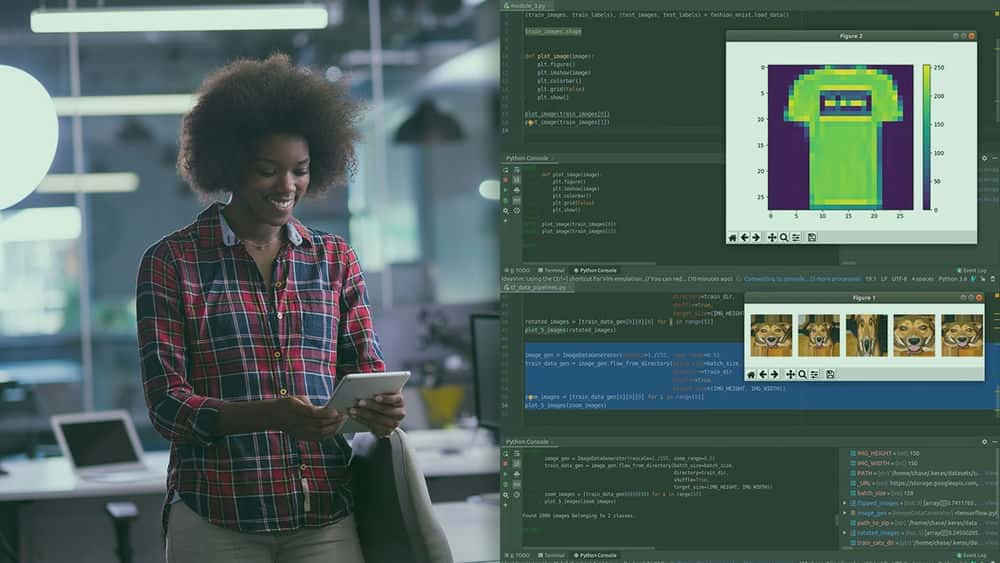

آموزش طراحی خطوط لوله داده با TensorFlow 2.0

Designing Data Pipelines with TensorFlow 2.0

این دوره یکی از بزرگترین تغییرات را از TensorFlow 1.0 به TensorFlow 2.0 - ماژول tf.data ارزیابی می کند. این رابط کاربری ساده و یکپارچه ، مدیریت خطوط لوله داده را با tf.data آسان می کند.

آموزش ساخت خطوط لوله داده دسته ای در GCP

Building Batch Data Pipelines on GCP

خطوط لوله داده معمولاً تحت یکی از پارادایم های Extra-Load، Extract-Load-Transform یا Extract-Transform-Load قرار می گیرند. این دوره توضیح می دهد که کدام پارادایم و چه زمانی باید برای داده های دسته ای استفاده شود. علاوه بر این، این دوره چندین فناوری را در Google Cloud Platform برای تبدیل داده ها از جمله BigQuery، اجرای Spark در Cloud Dataproc، نمودارهای خط لوله در Cloud Data Fusion و پردازش داده های بدون سرور با Cloud Dataflow را پوشش می دهد. یادگیرندگان تجربه عملی در ساخت اجزای خط لوله داده در پلتفرم Google Cloud با استفاده از QwikLabs خواهند داشت.

آموزش ساخت خطوط لوله داده دسته ای در GCP

Building Batch Data Pipelines on GCP

خطوط لوله داده معمولاً تحت یکی از پارادایم های Extra-Load، Extract-Load-Transform یا Extract-Transform-Load قرار می گیرند. این دوره توضیح می دهد که کدام پارادایم و چه زمانی باید برای داده های دسته ای استفاده شود. علاوه بر این، این دوره چندین فناوری را در Google Cloud Platform برای تبدیل داده ها از جمله BigQuery، اجرای Spark در Cloud Dataproc، نمودارهای خط لوله در Cloud Data Fusion و پردازش داده های بدون سرور با Cloud Dataflow را پوشش می دهد. یادگیرندگان تجربه عملی در ساخت اجزای خط لوله داده در پلتفرم Google Cloud با استفاده از QwikLabs خواهند داشت.

آموزش Data Science on Google Cloud Platform: ساخت خطوط لوله داده

Data Science on Google Cloud Platform: Building Data Pipelines

با نحوه طراحی و ساخت خطوط لوله داده بزرگ در Google Cloud Platform آشنا شوید.

Emilio Melo

Emilio Melo

Google Cloud

Google Cloud

Eugene Meidinger

Eugene Meidinger

Axel Sirota

Axel Sirota

Dan Tofan

Dan Tofan

Reza Salehi

Reza Salehi

Saravanan Dhandapani

Saravanan Dhandapani

Chase DeHan

Chase DeHan

Kumaran Ponnambalam

Kumaran Ponnambalam